LLaMA-Factory 答疑系列二:高频问题 + 官方解决方案,建议收藏备用

作为当下热门的大模型微调工具,LLaMA-Factory 凭借灵活的适配性和高效的训练能力,成为不少开发者的首选。

因此,我们联合LLaMA-Factory作者郑耀威博士,亲自开设了 《从零开始玩转LLaMA-Factory大模型微调》课程。别让明天的你,后悔今天没点开这篇文章:LLaMA-Factory作者亲授,带你抢占AI微调先机 课程上线后备受关注,有不少开发者和在校生报名参与学习。

在这个过程中,我们收集了不少学院反馈过来的问题,比如:显存溢出、微调效果不佳、训练卡住等问题却频繁出现。

上一期,我们整理了LLaMA-Factory 使用过程中的高频问题,今天继续整理《从零开始玩转LLaMA-Factory大模型微调》课程中的高频问题,附上官方认证的解决方案,不管你是刚入门的新手,还是有一定经验的开发者,都能快速找到答案,少走弯路!

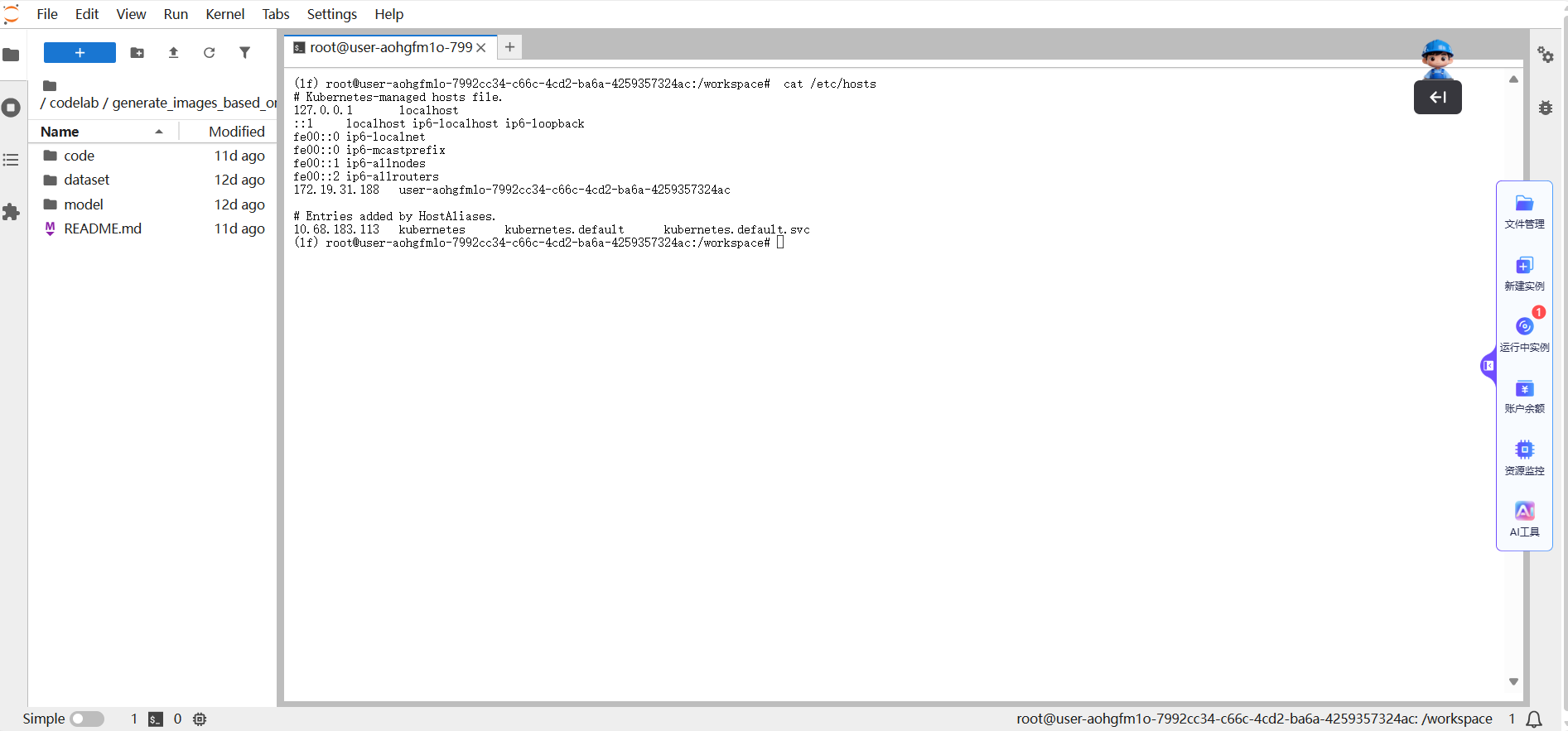

Q1:我同时在大模型实验室平台申请多台算力服务器,那么这些算力服务器之间可以进行通信吗?

A:支持的。您可以通过命令cat/etc/hosts 来查看ip,然后在另一个实例通过ip进行分布式推理或者训练。另外我们的基础设施是3.6TMbps的IB网络,默认已开启IB网络网卡。

Q2:如何学术资源加速?

A:用户可通过以下网站对文件进行加速代理:

(1)Github: 平台已内置了GitHub加速服务。您在执行Git相关命令时,将自动享受更快的访问与下载速度。

(2)HuggingFace镜像站: 平台已内置HuggingFace加速功能。您只需正常执行下载命令,系统将自动为您提速,无需额外配置。HuggingFace下载的模型占用系统盘空间很大,导致系统盘空间不够。默认HuggingFace的缓存模型会保存在/workspace/huggingface目录,可以将模型的缓存保存到文件存储的盘,具体操作如下:

(2.1)运行如下命令,使用清华大学PyPI镜像源安装Hugging Face官方的Python SDK huggingface_hub,以加速依赖下载。

pip install huggingface_hub -i https://pypi.tuna.tsinghua.edu.cn/simple

(2.2)运行以下命令,使用Hugging Face命令行工具(huggingface-cli)从指定仓库下载所需模型至指定路径。以下示例演示如何下载Qwen/Qwen2.5-1.5B-Instruct模型并保存到本地目录。

huggingface-cli download --resume-download Qwen/Qwen2.5-1.5B-Instruct --local-dir Qwen/Qwen2.5-1.5B-Instruct

Q3:为什么预训练样本数比实际的少?

A: 有用户反馈:LLaMA-Factory 预训练时,日志或界面显示的样本数量,比实际准备的训练样本数更少,担心数据未被充分利用。这是预训练阶段的默认优化机制 —— 自动启用了 Packing(样本打包) 功能。该机制会将多个短文本样本,按模型支持的最大序列长度(如 cutoff_len)打包成一条长序列进行训练,既避免了短样本导致的显存浪费,又能提升训练效率。因此,显示的 “打包后序列数” 会少于实际原始样本数,并非数据丢失,不影响训练效果。

Q4:模型微调界面,3个Job都是用 Lora 微调,但是 Lora 的 lora_alpha 参数选不同,为什么 trainable 的参数大小都是一样的呢 ?

A:lora_alpha的核心作用是调节参数更新幅度(稳定训练过程),而可训练参数量由 LoRA 秩 r 唯一决定,因此不同 lora_alpha 对应的可训练参数大小完全一致。

Q5:基于Qwen3-8B-Base 模型训练时,GPU 显存使用率随训练进程持续上升,最终因显存耗尽触发 OOM(Out Of Memory)错误,疑问该现象是否为内存泄漏,我该如何解决?

A:观察到的GPU 内存增长是深度学习训练中的正常行为,源于框架的内存优化策略(缓存),并非程序漏洞(内存泄漏)。如果训练能够长时间稳定运行而不崩溃,即使内存使用率较高,也通常是正常的。如果确实很快出现 OOM,则应考虑调整模型或训练参数。

实际应对措施:

接受这种内存增长行为,只要训练稳定即可。如果遇到 OOM,优先考虑调整以下参数来降低内存消耗:

- 减小 per_device_train_batch_size(批量大小)。

- 减小 Cutoff length。

- 使用梯度累积来模拟更大的批量大小。

- 启用梯度检查点(一种时间换空间的技术)。

- 考虑使用 deepspeed等更高效的内存优化工具。

Q6:训练VL(多模态)模型(如 Qwen3-VL、InternVL 等)时,数据集同时包含纯文本样本和多模态(图文)样本,不清楚纯文本样本该如何格式化,才能与多模态样本兼容?

A:纯文本样本需遵循多模态数据的统一格式规范,无需单独定义新格式,仅将“images” 字段显式留空即可(不可删除该字段)。

Q7:jupyter中,checkpoints文件夹打不开,也无法删除或者重命名,终端可以正常操作

A:Jupyter 中.ipynb_checkpoints 文件夹无法在 Web 界面操作,是因为它是 Jupyter 自动管理的系统目录,Web 界面对其进行了保护。解决方案包括:终端直接操作(删除 / 重命名)、修改 Jupyter 配置自定义检查点位置或禁用自动检查点。操作前需注意备份当前 Notebook 内容,避免丢失重要数据。

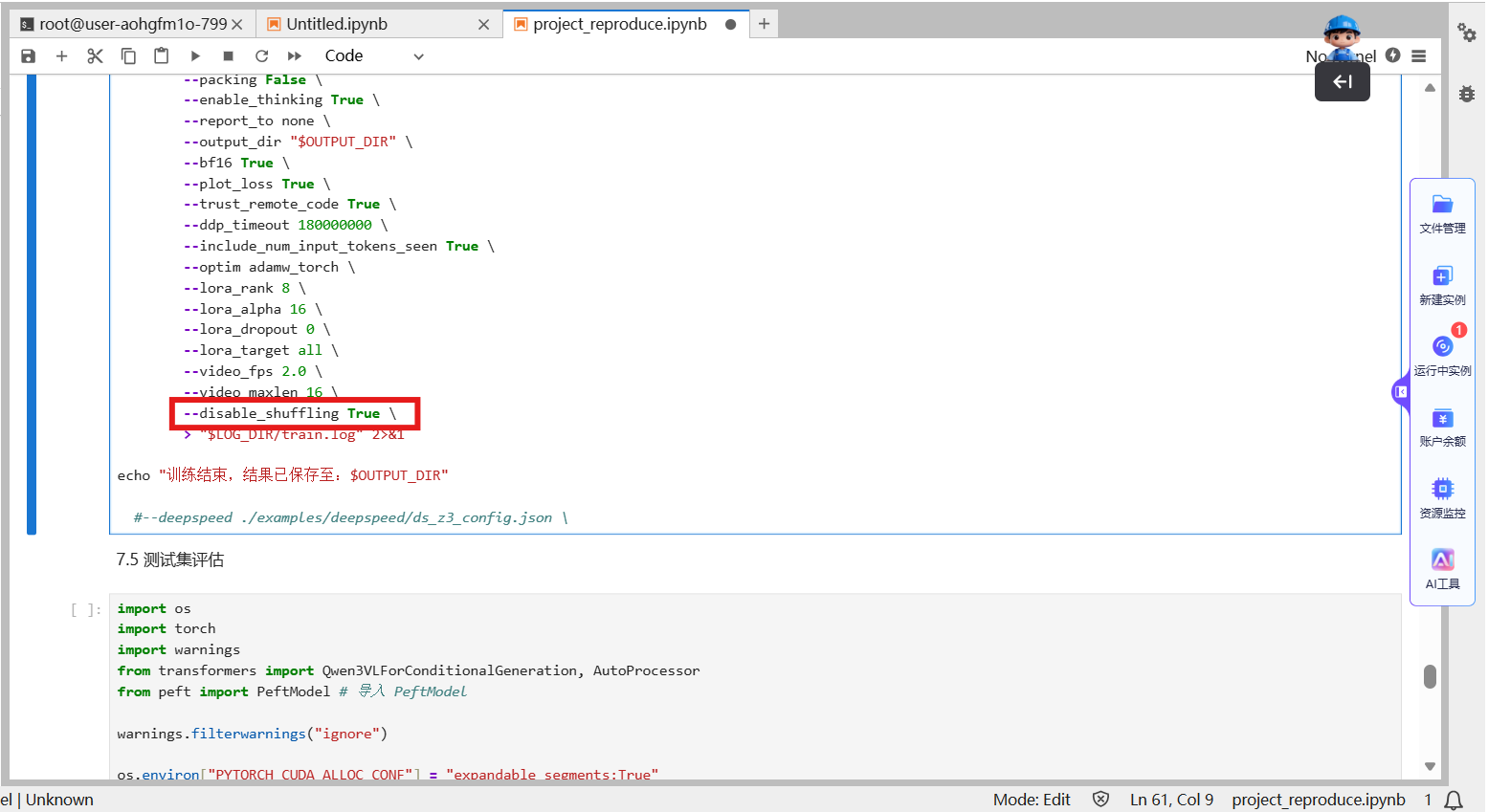

Q8:训练数据是否会自动随机打乱?若需固定数据顺序,该如何操作?

A:LLaMA-Factory 训练时默认会对训练数据进行随机打乱。

关闭打乱方法:若需固定数据顺序(如时序类任务、特定顺序训练场景),直接在训练配置文件中添加参数disable_shuffling: true 即可关闭随机打乱功能。

Q9: 模型回答胡乱或者重复

A:模型输出无逻辑胡乱回答、内容重复循环,本质是模型输入输出逻辑不匹配或学习过程出现偏差。该问题可能发生在训练前(原生模型/ 推理配置问题)或训练后(微调过程导致的适配偏差),需按场景针对性解决,核心关联模型类型、模板一致性、过拟合 / 欠拟合三大关键因素。

场景1:训练前就出现胡乱 / 重复回答(未微调时)

核心原因: 模型本身不具备“遵循指令” 能力,或推理模板与模型预期不匹配,导致模型无法理解任务逻辑。

可尝试下述方法解决:

1)更换 “对齐后” 的模型

问题本质:未经对齐的base 模型仅具备基础语言能力,无 “指令遵循”“对话逻辑” 训练,易输出无意义文本或重复内容;

解决方案:替换为instruct/chat 类对齐模型,这类模型已通过指令微调,能理解 “用户提问→合理回应” 的逻辑;

2)使用与模型匹配的正确模板(template)

问题本质:不同模型的prompt 模板格式要求不同,模板错误会让模型无法识别输入输出边界,导致回答错乱;

解决方案:① 优先使用 LLaMA-Factory 内置模板;② 若自定义模板,需遵循 “模型训练时的格式”(参考模型官方文档),确保包含清晰的角色分隔符;

避坑点:不要混合不同模型的模板,也不要省略角色标识。

3)调整推理生成参数

若模型和模板正确但仍重复,可降低生成温度temperature,同时设置 repetition_penalty;

限制最大生成长度max_new_tokens: 512,避免模型无限制重复同一内容。

场景2:训练后出现胡乱 / 重复回答(微调后效果倒退)

核心原因:微调过程中“输入输出逻辑传递不一致”,或模型学习过度(过拟合)、学习不足(欠拟合),导致生成偏差。

可尝试下述方法解决:

1)优先检查:训练与推理的模板是否完全一致

问题本质:微调时模型学习的是“特定模板下的输入输出映射”(如训练用 “用户提问:xxx 模型回答:xxx”),若推理时改用其他模板(如 “xxx?”),模型无法匹配训练时的学习逻辑,会输出混乱内容;

解决方案:① 确保训练配置(template 参数)与推理配置完全相同;② 若忘记训练时的模板,可在训练日志中搜索 “template” 关键词,或直接复用训练配置文件中的模板参数。

2)判断是否过拟合,针对性调整

过拟合表现:训练loss 持续下降(趋近于 0),但推理时回答重复、脱离任务(如无论问什么都输出训练数据中的某句话);

解决方案:① 降低训练强度:减小 num_train_epochs、调低 learning_rate;② 增加正则化;③ 扩充数据多样性:删除训练数据中的重复样本,补充不同场景的有效样本。

3)排查训练数据质量

问题本质:训练数据中存在大量重复、无意义、逻辑混乱的内容,模型会学到“重复输出” 的错误模式;

解决方案:① 清洗训练数据;② 确保数据逻辑一致;③ 控制数据长度,防止模型学习 “冗长重复” 的表达习惯。

4)补充微调优化:修正模型学习方向

若存在“欠拟合”:适当增加 num_train_epochs,或增大 LoRA 的影响力;若使用DPO/ORPO 微调:检查偏好数据的质量,避免模型学到错误的偏好逻辑。

以上就是 LLaMA-Factory 使用过程中最常见的9个问题及解决方案,建议收藏备用!如果在实战中遇到其他疑难问题,欢迎在评论区留言补充,后续会持续更新答疑系列~

觉得有用的话,别忘了点赞、在看、转发给身边需要的朋友呀!

👉点击购买

添加课程优惠官,了解课程详情

创作者招募中!Lab4AIxLLaMA-Factory邀你共创实战资源

想解锁大模型微调实战,却愁无算力、缺平台?现在机会来了!Lab4AI联合LLaMA-Factory启动创作者招募,诚邀AI开发者、学生及技术爱好者提交微调实战案例,通过审核即享算力补贴与官方证书等,共创AI实践新生态。

大模型实验室Lab4AI实现算力与实践场景无缝衔接,具备充足的H卡算力,支持模型复现、训练、推理全流程使用。

Lab4AI大模型实验室还能做什么

作为算力驱动的AI实践内容生态社区,它不是普通的代码仓库,而是集代码、数据、算力与实验平台于一体的平台,项目中预装虚拟环境,让您彻底告别“环境配置一整天,训练报错两小时”的窘境。

论文板块

覆盖从顶刊论文获取(Arxiv速递、论文查询)、处理(翻译、分析、导读、笔记)、复现,到科研成果转化的全环节,为科研人提供一站式工具与资源。

AI课程板块

打造“学练结合”模式,课程配套可运行实验,从模型拼接原理到训练代码实现,每一步都有实操支撑,有效降低“懂理论不会动手”的学习门槛。

LLaMA Factory官方微调课程,早鸟价450元=开源作者亲授+配套300元算力+完课证书+微调手册+答疑社群,带您从理论到实践,一站式掌握大模型定制化的核心技能。