双目三维重建的步骤与核心算法

双目三维重建是模拟人类双眼视觉原理,通过两个固定位置的相机拍摄同一场景,利用视差计算三维坐标的技术,广泛应用于机器人导航、自动驾驶、三维建模等领域。其流程可分为六大核心步骤,每个步骤对应关键算法与实现细节,以下从通俗原理→数学模型→核心算法→代码思路逐层讲解。

一、整体流程概览

双目三维重建的核心逻辑是:通过相机标定获取内外参数→对左右图像进行校正→计算像素间的视差→利用三角测量恢复三维点云→点云后处理得到稠密模型。

整体流程如下:

相机标定 → 图像校正 → 立体匹配(视差计算) → 三角测量 → 点云后处理

二、各步骤详细解析

步骤1:相机标定(获取内外参数与畸变系数)

通俗解释

双目相机由左右两个相机组成,出厂时无法保证完全平行和对齐。相机标定的目的是:

- 单目标定:获取每个相机的内参数(焦距、主点坐标)和畸变系数(径向畸变、切向畸变),消除镜头畸变。

- 双目标定:获取左右相机的外参数(旋转矩阵R和平移向量T),描述两个相机的相对位置关系。

数学原理

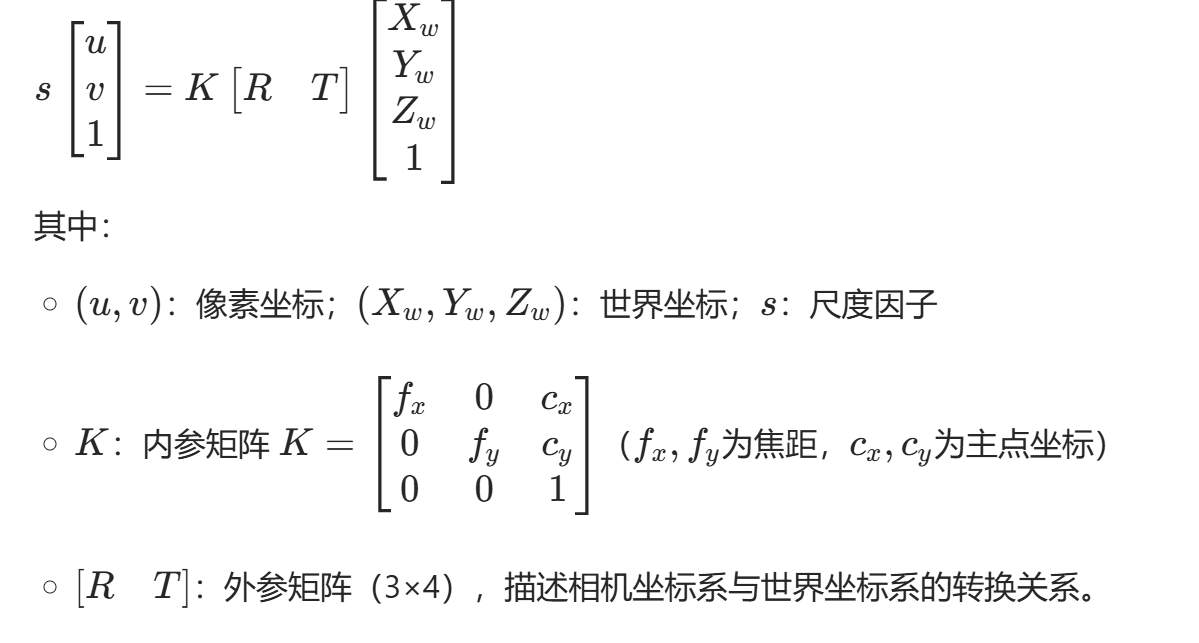

-

针孔相机模型(像素坐标→归一化坐标→世界坐标)

-

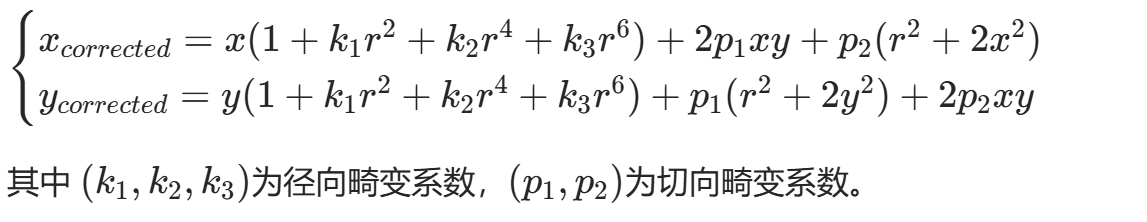

畸变模型:镜头畸变分为径向畸变(桶形/枕形)和切向畸变,校正公式为:

核心算法

- 张氏标定法(最常用):使用棋盘格标定板,通过多视角拍摄的标定板图像,求解相机参数。

- 核心思想:利用棋盘格的角点(已知世界坐标)与像素坐标的对应关系,通过最大似然估计求解内外参数。

- 标定工具:OpenCV

calibrateCamera(单目标定)、stereoCalibrate(双目标定)。

代码思路(C++/OpenCV)

// 1. 读取棋盘格图像,提取角点

vector<vector<Point2f>> imagePoints; // 存储所有图像的角点像素坐标

vector<vector<Point3f>> objectPoints; // 棋盘格角点的世界坐标(Z=0)

Size boardSize(9,6); // 棋盘格内角点数量

for (auto& img : images) {vector<Point2f> corners;bool found = findChessboardCorners(img, boardSize, corners);if (found) {cornerSubPix(img, corners, Size(11,11), Size(-1,-1), TermCriteria(...));imagePoints.push_back(corners);objectPoints.push_back(generate3DPoints(boardSize, squareSize)); // 生成世界坐标}

}

// 2. 单目标定(左相机)

Mat K_left, D_left;

calibrateCamera(objectPoints, imagePoints_left, imgSize, K_left, D_left, rvecs, tvecs);

// 3. 双目标定

Mat R, T, E, F;

stereoCalibrate(objectPoints, imagePoints_left, imagePoints_right,K_left, D_left, K_right, D_right, imgSize, R, T, E, F);

步骤2:图像校正(消除畸变+极线对齐)

通俗解释

未经校正的左右图像存在畸变,且极线不平行(极线:空间点在左右图像上的投影点连线)。校正的目的是:

- 对左右图像进行畸变校正,消除镜头畸变。

- 将左右相机的图像平面调整为严格平行,使得极线与图像水平方向一致(行对齐)。校正后,同一空间点在左右图像上的投影点位于同一行,极大简化后续的立体匹配。

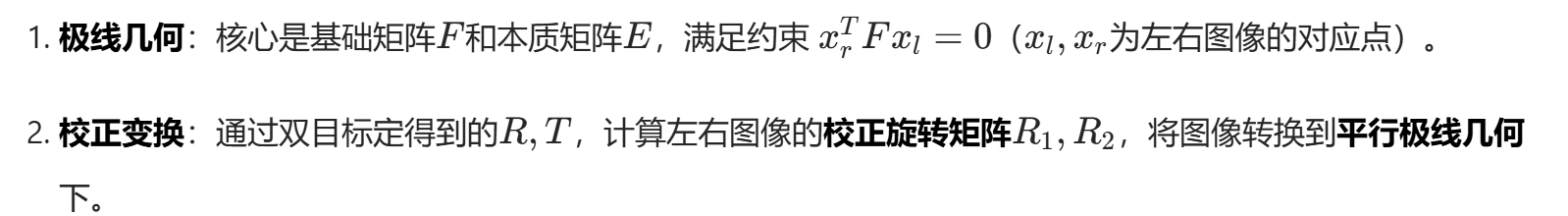

数学原理

- 重投影:利用校正旋转矩阵和内参矩阵,计算图像的映射矩阵(remap),对原始图像进行重采样得到校正后的图像。

核心算法

- Bouguet校正算法(OpenCV默认):基于最小重投影误差,计算最优的校正旋转矩阵,保证极线严格水平对齐。

- 映射计算:通过

stereoRectify计算校正参数,initUndistortRectifyMap生成映射表,remap执行图像重采样。

代码思路(C++/OpenCV)

// 1. 计算校正参数

Mat R1, R2, P1, P2, Q; // Q为重投影矩阵(用于视差→深度转换)

stereoRectify(K_left, D_left, K_right, D_right, imgSize, R, T, R1, R2, P1, P2, Q,CALIB_ZERO_DISPARITY, -1, imgSize, &roi1, &roi2);

// 2. 生成映射表

Mat map1_left, map2_left, map1_right, map2_right;

initUndistortRectifyMap(K_left, D_left, R1, P1, imgSize, CV_32FC1, map1_left, map2_left);

initUndistortRectifyMap(K_right, D_right, R2, P2, imgSize, CV_32FC1, map1_right, map2_right);

// 3. 执行校正

Mat img_left_rect, img_right_rect;

remap(img_left, img_left_rect, map1_left, map2_left, INTER_LINEAR);

remap(img_right, img_right_rect, map1_right, map2_right, INTER_LINEAR);

步骤3:立体匹配(计算视差图)

通俗解释

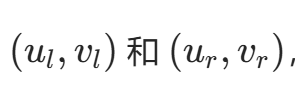

视差是同一空间点在左右图像上的投影点横坐标之差,公式为 d = u_l - u_r(u_l,u_r为左右图像的横坐标)。视差与深度成反比,深度越大,视差越小。

立体匹配的核心是:对左图像的每个像素,在右图像的同一行中找到最佳匹配的像素,计算视差,最终生成视差图(每个像素值为视差)。

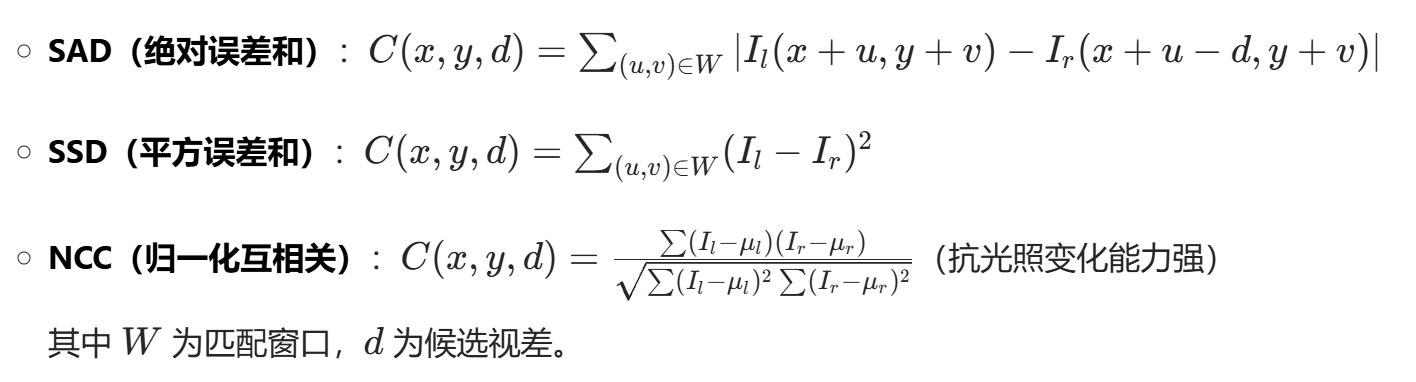

数学原理

-

匹配代价计算:衡量左右图像像素块的相似度,常用代价函数:

-

代价聚合:对初始代价进行空间域聚合,抑制噪声(如动态规划、置信传播、半全局匹配SGM)。

-

视差计算:通过赢家通吃(WTA) 策略,选择代价最小的候选视差作为最优视差。

-

视差优化:消除视差图中的噪声、空洞,如左右一致性检查、亚像素插值、中值滤波。

核心算法

| 算法类型 | 代表算法 | 优点 | 缺点 |

|---|---|---|---|

| 局部算法 | SAD/SSD/NCC | 计算速度快、易于并行 | 匹配精度低、对纹理缺失敏感 |

| 全局算法 | 半全局匹配(SGM) | 精度高、鲁棒性强 | 计算复杂度中等 |

| 深度学习算法 | PSMNet/GC-Net | 精度最高、适应复杂场景 | 依赖大量数据、推理速度慢 |

工业级首选:SGM算法——兼顾速度与精度,是OpenCV、PCL等库的默认立体匹配算法。

代码思路(C++/OpenCV SGM)

// 1. 创建SGM立体匹配器

Ptr<StereoSGBM> sgbm = StereoSGBM::create(0, // 最小视差16, // 视差范围(最大视差=最小视差+视差范围)3, // 匹配窗口大小8*3*3, // 代价参数132*3*3,// 代价参数21, // 唯一性检测阈值0, // 纹理阈值0, // 视差连续性阈值true, // 启用亚像素插值StereoSGBM::MODE_SGBM_3WAY // 匹配模式

);

// 2. 计算视差图

Mat disp, disp8;

sgbm->compute(img_left_rect, img_right_rect, disp);

// 3. 视差图优化(转换为8位图像)

disp.convertTo(disp8, CV_8U, 255/(16*16.0)); // 视差值归一化到0-255

// 4. 左右一致性检查+中值滤波

Mat disp_filtered;

medianBlur(disp8, disp_filtered, 3);

步骤4:三角测量(视差→深度→三维点云)

通俗解释

校正后的图像满足平行极线几何,结合相机标定得到的重投影矩阵$Q$,可直接将视差图转换为深度图,再通过三角测量计算每个像素的三维坐标。

数学原理

-

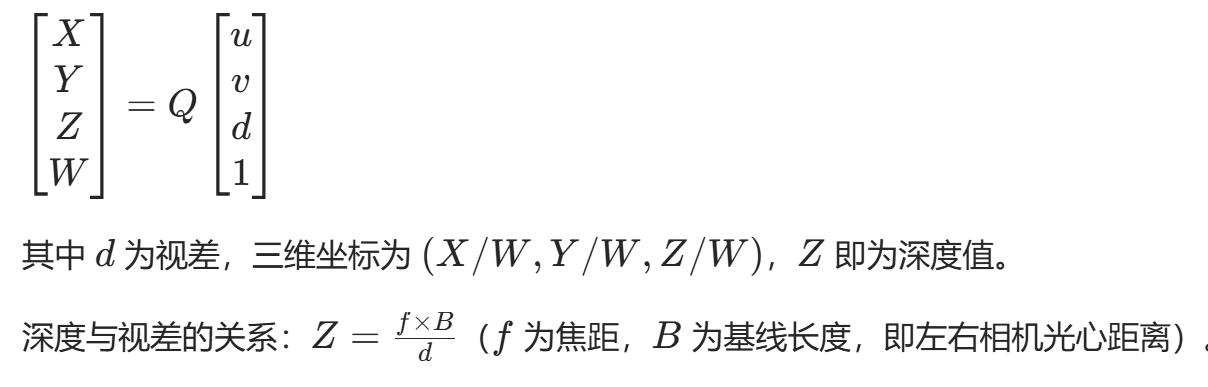

视差→深度转换:由重投影矩阵Q实现,公式为:

-

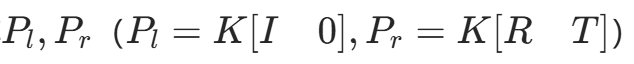

三角测量:对于左右图像的对应点

,利用相机内外参数,通过最小二乘法求解空间点的三维坐标。

核心算法

- 线性三角测量:利用投影矩阵

,构建线性方程组求解三维点。 - 重投影矩阵法:OpenCV通过

reprojectImageTo3D函数直接将视差图转换为三维点云,无需手动实现三角测量。

代码思路(C++/OpenCV 点云生成)

// 1. 视差图→三维点云(注意:输入视差图为16位有符号数)

Mat xyz;

reprojectImageTo3D(disp, xyz, Q, true); // true表示深度值以米为单位

// 2. 提取有效点云(去除背景和无效点)

vector<Point3f> point_cloud;

vector<Vec3b> colors;

Mat img_left = imread("left.jpg");

for (int y = 0; y < img_left.rows; y++) {for (int x = 0; x < img_left.cols; x++) {Vec3f point = xyz.at<Vec3f>(y, x);float z = point[2];if (z > 0 && z < 10) { // 过滤深度范围0-10米的点point_cloud.push_back(Point3f(point[0], point[1], point[2]));colors.push_back(img_left.at<Vec3b>(y, x)); // 点云染色}}

}

// 3. 保存点云为PLY格式(用于MeshLab可视化)

savePLY("point_cloud.ply", point_cloud, colors);

步骤5:点云后处理(稠密模型生成)

通俗解释

直接生成的点云存在噪声、离群点、空洞,需要后处理以得到高质量的稠密点云,最终可通过泊松重建/Alpha Shapes等算法生成三维网格模型。

核心算法

- 点云滤波:

- 离群点去除:统计滤波(PCL

StatisticalOutlierRemoval)、半径滤波(RadiusOutlierRemoval)。 - 下采样:体素滤波(

VoxelGrid),降低点云密度,加速后续处理。

- 离群点去除:统计滤波(PCL

- 点云配准(多视角融合时需要):ICP(迭代最近点)算法,将多帧点云对齐到同一坐标系。

- 稠密重建:

- 泊松重建:从点云生成光滑的三维网格模型。

- Alpha Shapes:适用于表面重建,生成更贴近原始点云的模型。

代码思路(C++/PCL 点云后处理)

// 1. 转换为PCL点云格式

pcl::PointCloud<pcl::PointXYZRGB>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZRGB>);

for (int i = 0; i < point_cloud.size(); i++) {pcl::PointXYZRGB p;p.x = point_cloud[i].x;p.y = point_cloud[i].y;p.z = point_cloud[i].z;p.r = colors[i][2]; p.g = colors[i][1]; p.b = colors[i][0];cloud->push_back(p);

}

// 2. 统计滤波去除离群点

pcl::StatisticalOutlierRemoval<pcl::PointXYZRGB> sor;

sor.setInputCloud(cloud);

sor.setMeanK(50); // 邻域点数

sor.setStddevMulThresh(1.0); // 标准差阈值

sor.filter(*cloud_filtered);

// 3. 体素下采样

pcl::VoxelGrid<pcl::PointXYZRGB> vg;

vg.setInputCloud(cloud_filtered);

vg.setLeafSize(0.01f, 0.01f, 0.01f); // 体素大小

vg.filter(*cloud_downsampled);

// 4. 泊松重建生成网格

pcl::Poisson<pcl::PointXYZRGB> poisson;

poisson.setInputCloud(cloud_downsampled);

poisson.setDepth(8); // 重建深度

pcl::PolygonMesh mesh;

poisson.reconstruct(mesh);

三、关键优化技巧(提升重建精度与速度)

- 硬件层面:

- 选择基线长度合适的双目相机:基线越长,视差越大,深度测量精度越高,但有效测量距离越远;反之则相反。

- 启用CUDA加速:立体匹配(SGM)、点云滤波等步骤可通过CUDA并行计算,速度提升10-100倍(如OpenCV的

cuda::StereoSGM)。

- 算法层面:

- 采用亚像素插值:将视差精度从整数提升到0.1-0.5像素,显著提高深度测量精度。

- 加入左右一致性检查:剔除错误匹配的视差点,减少点云噪声。

- 工程层面:

- 对图像进行预处理:如灰度化、直方图均衡化,增强图像纹理,提升匹配鲁棒性。

- 针对低纹理区域:结合深度学习立体匹配算法(如PSMNet),弥补传统算法的不足。

四、常见问题与解决方案

| 问题 | 现象 | 解决方案 |

|---|---|---|

| 视差图空洞 | 视差图存在大量黑色空洞 | 1. 增大匹配窗口;2. 左右一致性检查后填充;3. 中值滤波 |

| 深度值不准确 | 点云拉伸或压缩 | 1. 重新标定相机(提高标定精度);2. 优化SGM参数;3. 亚像素插值 |

| 点云噪声大 | 点云存在大量离群点 | 1. 统计滤波/半径滤波;2. 提高图像分辨率;3. 增强图像纹理 |

五、总结

双目三维重建的核心是极线几何约束和视差计算,各步骤的优先级为:

相机标定精度 > 图像校正质量 > 立体匹配算法选择 > 点云后处理

对于C++开发者,推荐使用OpenCV+PCL+CUDA的技术栈,兼顾实时性与精度,适用于机器人导航、三维扫描等工业场景。