在 618 大促的技术战场上,每一行代码、每一个配置都影响着一线的实实在在的业务。一次看似平常的发版,却意外暴露了我们系统中的定时任务管理短板,这促使我们深入剖析分布式任务调度中异常重试机制的技术细节,并最终将其转化为守护系统稳定性的坚固防线。

一、异常事件回溯:隐藏在发版背后的定时炸弹

发版次日,业务部门反馈商家未收到门店收货明细邮件,导致门店收货业务收到影响。技术团队迅速启动应急流程,通过全链路日志追踪和系统状态分析,发现了问题的根源是:发版过程中,由于服务重启,中断了定时任务进程,正在执行的邮件发送任务被意外终止。而该任务在管理平台上并未配置任何重试策略,业务代码上也没有进行相关的检测和重试,这就导致任务失败后无法自动恢复执行,也未被及时感知到,进而引发业务阻断。

为解决燃眉之急,研发人员立即登录任务管理平台,手工触发邮件发送任务,确保业务及时恢复。但这次事件给我们敲响了警钟:在分布式任务调度场景下,面对网络抖动、进程异常终止等场景,异常重试机制是保障业务可靠性的关键。

二、重试策略设计:从理论到代码的深度解析

2.1 验证EasyJob的重试策略

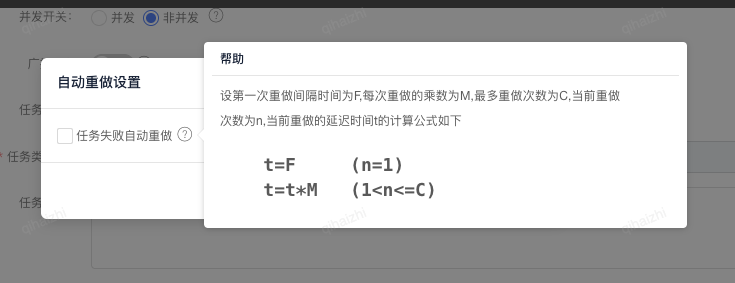

在复盘问题的过程中,我们发现了EasyJob分布式任务是具有重试策略的,只是默认不开启,而不是默认开启。

该策略以三个核心参数为基础:首次重试间隔时间 F、重试间隔乘数 M 和最大重试次数 C。

通过这三个参数的组合,我们可以灵活控制任务重试节奏,平衡系统负载与任务恢复效率。

例如:配置t=10s, M=2, C=10,则间隔时间依次是:

| 间隔时间计算方式 | 间隔时间结果 | |

|---|---|---|

| 1 | 10s(初始间隔,无计算) | 10s |

| 2 | 10s×2 | 20s |

| 3 | 20s×2 | 40s |

| 4 | 40s×2 | 80s |

| 5 | 80s×2 | 160s |

验证日志:

21:45:29.990 [main-schedule-worker-pool-1-thread-1] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务

21:45:40.204 [main-schedule-worker-pool-1-thread-2] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务

21:46:00.674 [main-schedule-worker-pool-1-thread-3] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务

21:46:41.749 [main-schedule-worker-pool-1-thread-4] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务

21:48:02.398 [main-schedule-worker-pool-1-thread-5] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务

21:50:43.008 [main-schedule-worker-pool-1-thread-1] INFO cn.jdl.tech_and_data.EmailSendingTask - 开始执行发送邮件任务| 任务序号 | 开始时间 | 与前一任务的间隔 |

|---|---|---|

| 第 1 个任务 | 21:45:29.990 | - |

| 第 2 个任务 | 21:45:40.204 | 10.214 秒 |

| 第 3 个任务 | 21:46:00.674 | 20.47 秒 |

| 第 4 个任务 | 21:46:41.749 | 41.075 秒 |

| 第 5 个任务 | 21:48:02.398 | 80.649 秒(约 1 分 20.65 秒) |

| 第 6 个任务 | 21:50:43.008 | 160.61 秒(约 2 分 40.61 秒) |

与上面计算的一致。

验证方案:

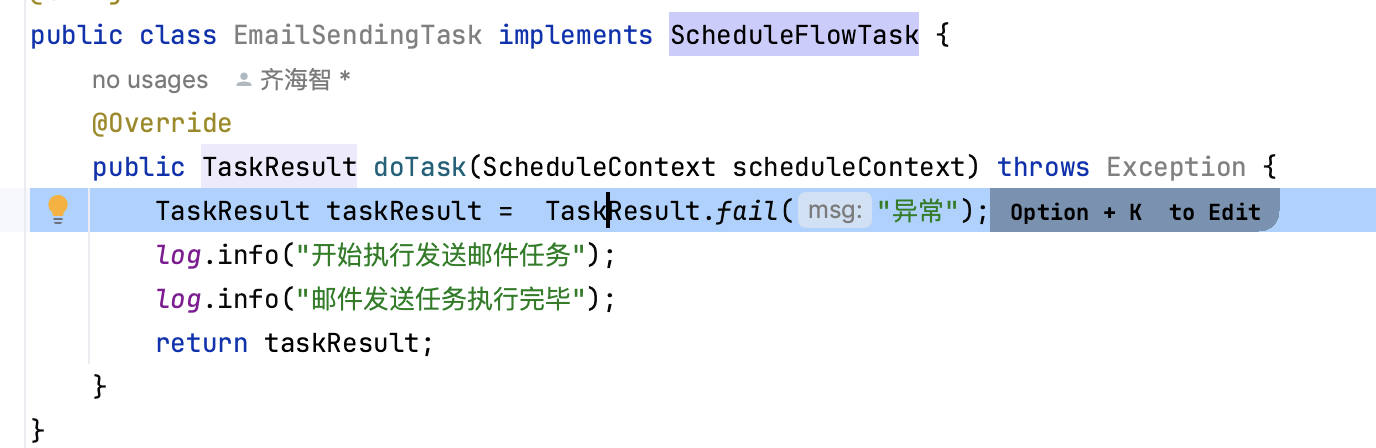

1、实现接口:com.wangyin.schedule.client.job.ScheduleFlowTask,并设置任务返回失败:

2、创建CRON触发器

3、设置自动重试参数

4、暂停任务并手工触发一次

2.2 实现一个简单的重试策略

根据上述策略,简单实现了一个灵活可配置的任务重试机制。

public class TaskRetryExecutor {@Getterprivate final ScheduledExecutorService executor = newScheduledThreadPool(10);private final long firstRetryInterval;private final int intervalMultiplier;private final int maxRetryCount;public TaskRetryExecutor(long firstRetryInterval, int intervalMultiplier, int maxRetryCount) {this.firstRetryInterval = firstRetryInterval;this.intervalMultiplier = intervalMultiplier;this.maxRetryCount = maxRetryCount;}public void submitRetryableTask(Runnable task) {executeWithRetry(task, 1);}private void executeWithRetry(Runnable task,