DeepSeek提出mHC,改造何恺明残差连接

大模型实验室Lab4AI论文阅读

✔️研究背景

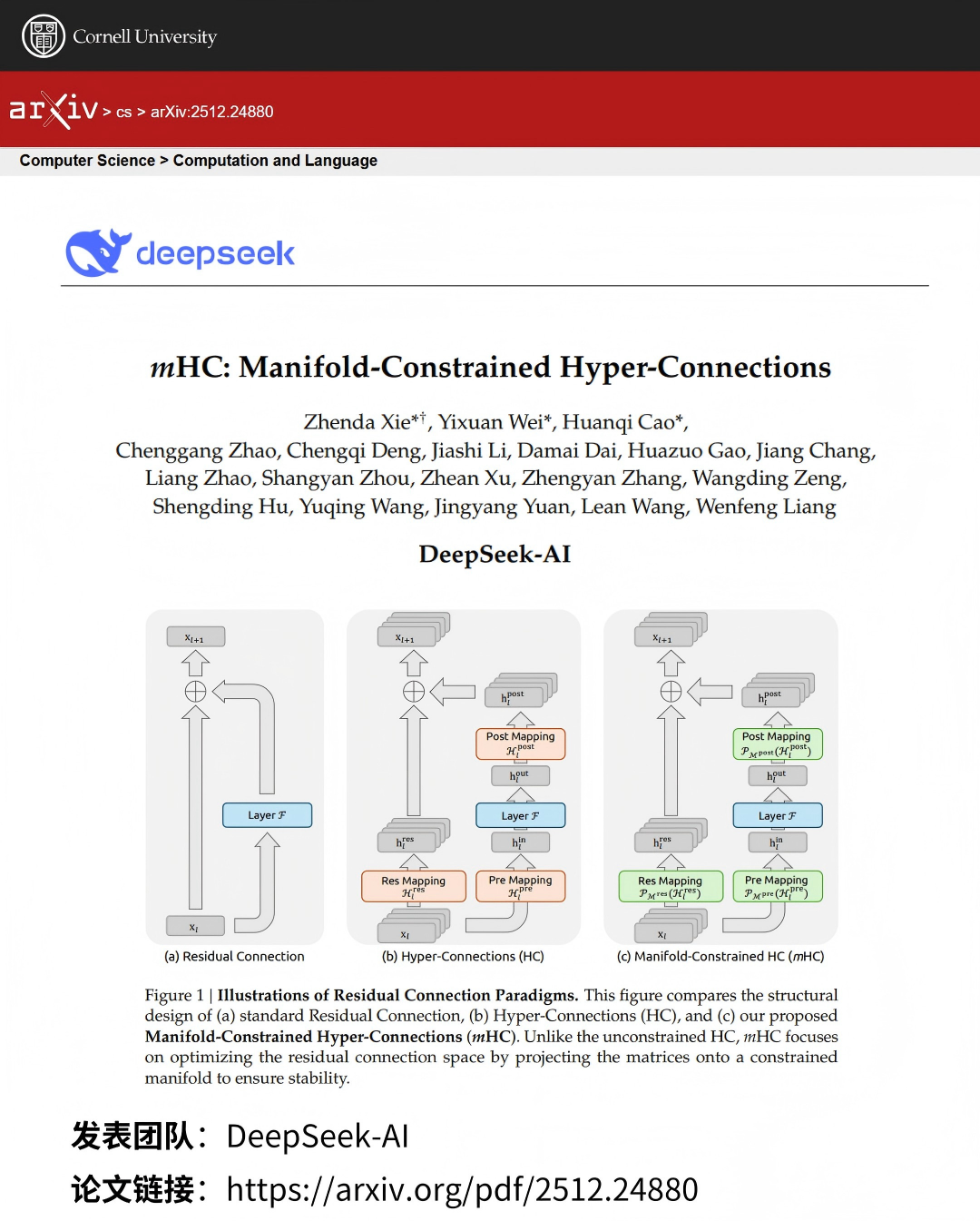

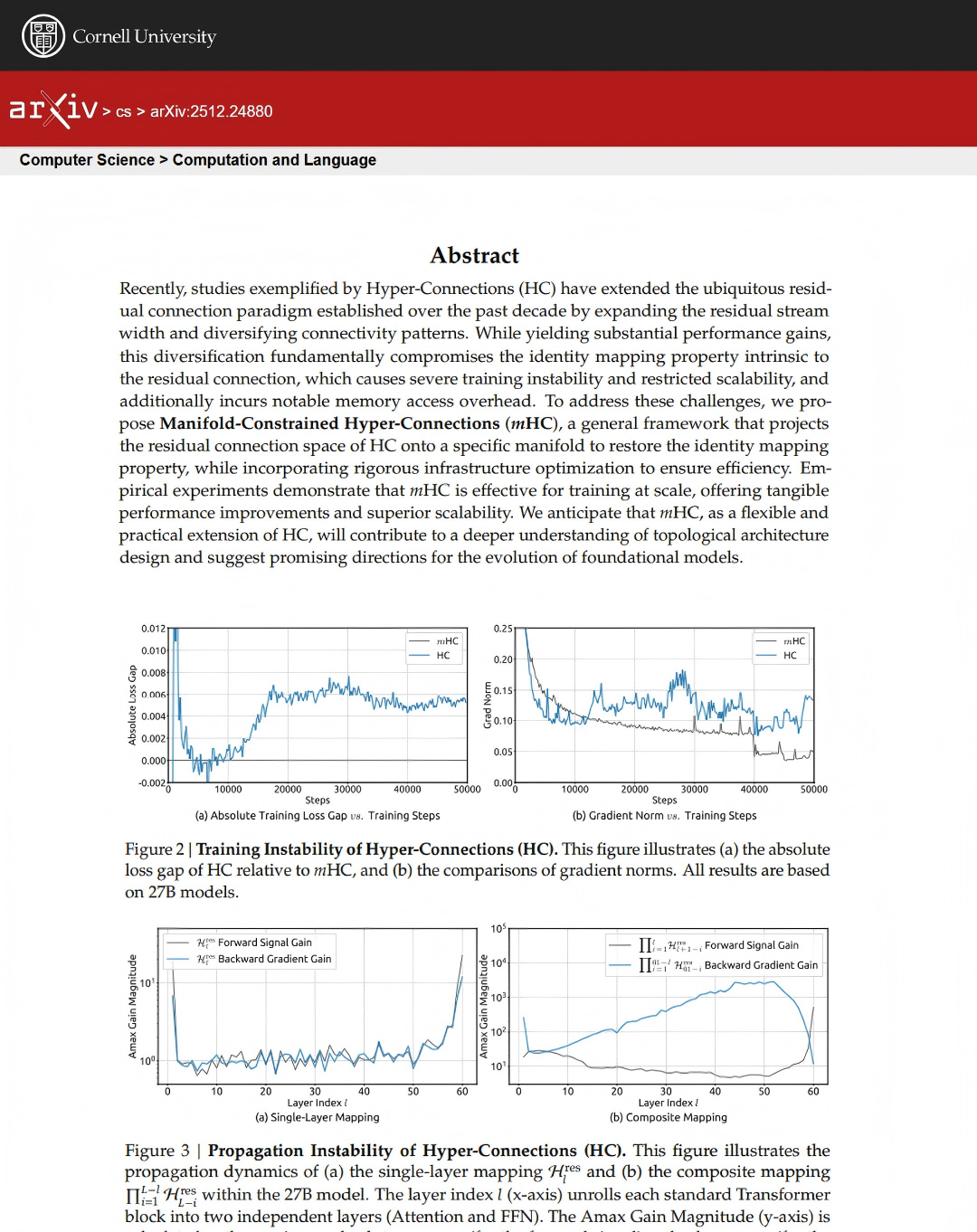

深度学习中,残差连接 是 ResNet、Transformer 等架构(含 LLM)的基础,其恒等映射特性保障了大规模训练的稳定性与效率。Hyper-Connections(HC)通过扩展残差流宽度、多样化连接模式提升模型性能,但因连接无约束,破坏了恒等映射特性,导致训练不稳定、扩展性受限,且存在显著内存访问与通信开销,这一问题限制了 HC 在大规模训练中的实际应用,形成研究缺口。

✔️研究目的

本文解决 HC 架构存在的训练不稳定性、扩展性差及系统开销大的核心问题,同时保留 HC 扩展残差连接带来的性能优势,提出一种兼顾稳定性、扩展性与效率的通用残差连接框架,支撑大规模深度学习模型(尤其是 LLM)的高效训练。

✔️核心贡献

提出 Manifold-Constrained Hyper-Connections(mHC)框架,通过将 HC 的残差映射投影到双随机矩阵流形(Birkhoff 多面体),恢复恒等映射特性,保障信号传播稳定性;

对输入 / 输出映射施加非负约束,避免信号抵消,同时通过核融合、选择性重计算、DualPipe 通信重叠等基础设施优化,降低系统开销;

实证验证 mHC 在大规模预训练中的有效性,为深度网络拓扑架构设计提供新视角,推动基础模型的演进。

✔️研究方法

- 1)核心方法论:采用 Sinkhorn-Knopp 算法将残差映射 H_res 熵投影到双随机矩阵流形,对 H_pre 和 H_post 用 Sigmoid 函数施加非负约束;

- 2)基础设施优化:基于 TileLang 实现混合精度核融合,通过选择性重计算降低内存占用,扩展 DualPipe 调度实现通信与计算重叠;

- 3)实验设计:在3B至27B参数的语言模型上进行预训练实验,对比基线、HC和mHC的稳定性、下游任务性能及缩放特性。

✔️研究结果

- 1)稳定性提升:mHC在27B模型训练中消除HC的损失突增现象,梯度范数保持稳定(对比HC的3000倍信号增益峰值,mHC最大增益仅1.6倍)。

- 2)性能优势:在推理、阅读理解、数学问题解决等任务上全面优于基线和 HC,27B 模型在 BBH 上较 HC 提升 2.1%;

- 3)扩展性与效率:支持模型规模与训练数据量的高效扩展,n=4 时仅增加 6.7% 时间开销,显著降低内存访问与通信成本。