RAG 选型避坑:5 种主流方案对比,轻量场景 vs 大规模场景怎么选?

RAG选型核心逻辑,避开90%团队踩过的坑

最近和多家企业的AI技术负责人深度交流,发现一个共性痛点:RAG(检索增强生成)作为解决大模型“知识过期”“幻觉”的核心技术,80%的团队都在选型上栽了跟头——要么用轻量方案硬扛大规模数据,导致检索延迟飙升至3秒以上;要么用复杂方案给小场景做“过度设计”,服务器成本翻倍却没提升效果。

印象很深的一个案例:某教育公司初期为了“一步到位”,直接上了“RAG+微调+分布式向量库”的复杂架构,处理仅5万条的课程文档,结果P99响应时间高达2.8秒,每月服务器成本多花2万;后来调整为基础RAG方案,配合轻量级向量库,响应时间压到280ms,成本直接降低70%。

反过来,某电商平台曾用基础RAG处理1000万条商品FAQ,召回率不足60%,用户长尾问题大多无法匹配;升级为“增强RAG+混合检索”后,召回率提升至92%,客服咨询效率提升40%。

这两个案例戳中了RAG选型的核心矛盾:没有“最好的方案”,只有“最适配场景的方案”。对于中级及以上技术人员来说,选型的关键不是罗列技术特性,而是掌握“场景-指标-方案”的匹配逻辑,以及不同场景下的实操落地技巧。

今天这篇文章,基于10+企业级RAG落地经验,拆解5种主流RAG方案的底层逻辑、实测效果,给出“轻量场景(数据量<10万条,并发<100 QPS)”和“大规模场景(数据量>100万条,并发>500 QPS)”的选型框架与实操步骤,帮你精准避坑。

技术原理:先搞懂——5种RAG方案的核心差异在哪?

在讲选型前,先理清RAG的核心逻辑:RAG本质是“检索+生成”的组合,通过检索工具从私有知识库中抓取相关信息,再传给大模型生成答案,核心解决“大模型没学过的知识”问题。

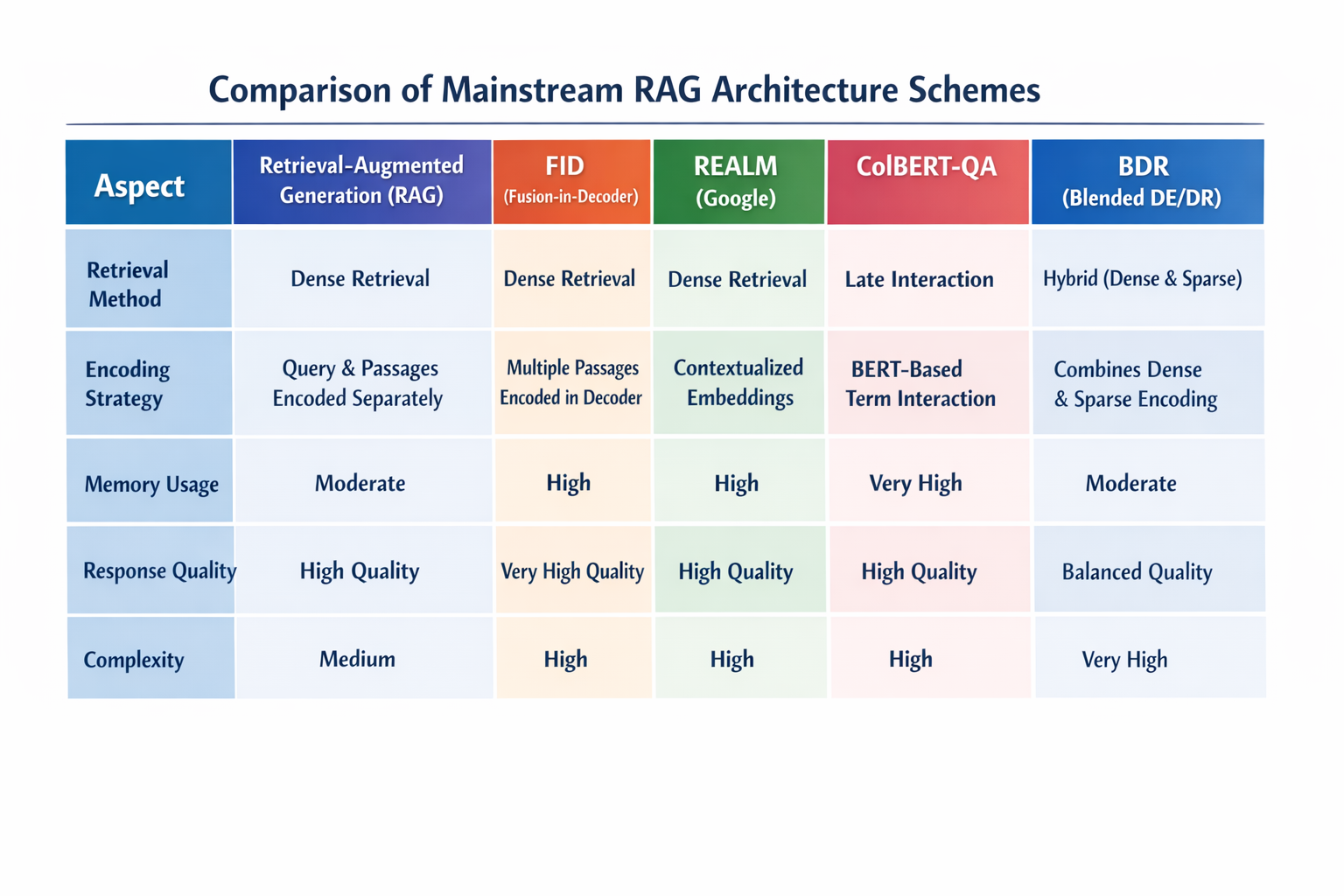

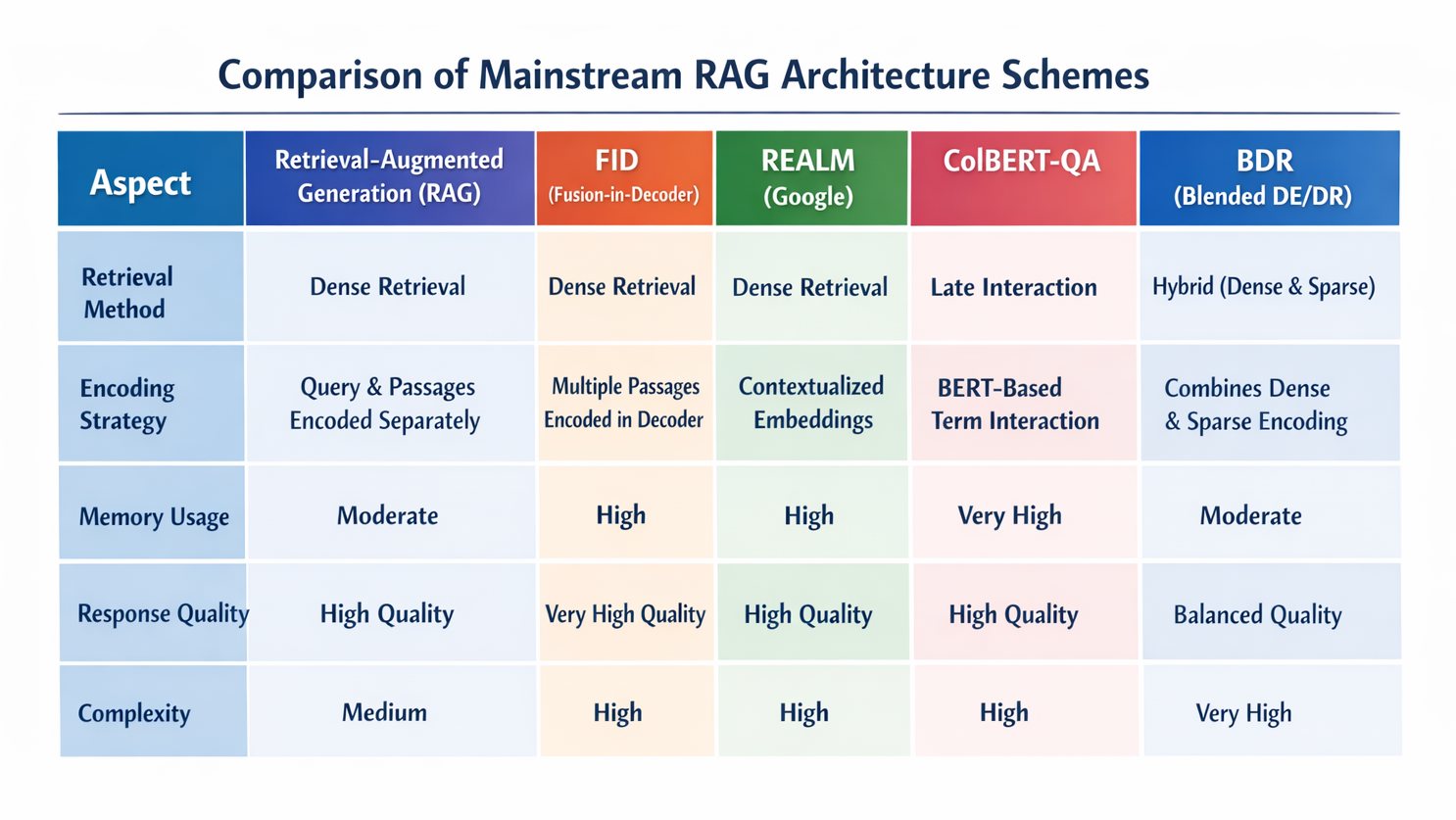

5种主流方案的差异,本质是“检索策略、文档处理方式、与大模型的融合度”三个维度的不同,我们从底层逻辑拆解,避免单纯记概念:

核心概念铺垫

- 检索策略:决定“怎么找”——比如仅按语义匹配(向量检索)、仅按关键词匹配(BM25)、两者结合(混合检索);

- 文档处理:决定“找什么粒度的信息”——比如按固定长度分片(基础方案)、按语义边界分片(增强方案)、结构化解析(多模态方案);

- 融合度:决定“检索结果怎么用”——比如直接传给大模型(基础方案)、重排后再传(增强方案)、结合微调优化(混合方案)。

5种主流方案的深度拆解(底层逻辑+适用场景)

1. 基础RAG方案(文档分片+纯向量检索+直接生成)

- 底层逻辑:最简化的RAG架构,把文档按固定长度(如512字符)分片,用embedding模型转成向量存入轻量级向量库;用户提问时,向量库检索Top-K相关片段,直接传给大模型生成答案。

- 核心优势:架构简单、部署成本低、开发周期短(1-2周可落地);

- 核心短板:召回率依赖分片质量(固定长度易割裂语义)、纯向量检索对关键词不敏感(比如用户问“退款流程”,文档中是“退货退款步骤”,可能匹配不到)、不支持大规模数据(向量库单节点性能瓶颈);

- 适用场景:轻量场景——个人知识库、小团队文档中心、数据量<10万条、并发<100 QPS、对响应时间要求不极致(<500ms)。

2. 增强RAG方案(语义分片+检索重排+上下文扩展)

- 底层逻辑:在基础方案上做三大优化——①按语义分片(用LLM判断语义边界,避免割裂);②检索后加重排模块(用Cross-BERT等模型对Top-K结果二次排序,提升相关性);③上下文扩展(根据用户提问补全关键词,比如用户问“退款”,自动扩展为“退款流程、退货退款、退款条件”)。

- 核心优势:召回率比基础方案高20%-30%、语义匹配更精准、支持中大规模数据(10万-100万条);

- 核心短板:比基础方案多2个模块,部署和调优成本略高、重排模块会增加100-200ms响应时间;

- 适用场景:中大规模场景——企业级文档平台、电商客服FAQ、数据量10万-100万条、并发100-500 QPS、对召回率要求高(>85%)。

3. 混合检索RAG方案(BM25+向量检索+加权融合)

- 底层逻辑:解决纯向量检索对关键词不敏感的问题,同时启用“关键词检索(BM25)”和“语义检索(向量检索)”,两种结果按权重融合(如向量检索占70%,BM25占30%)后传给大模型。

- 核心优势:兼顾语义和关键词匹配,召回率比纯向量检索高15%-25%、对文档格式不敏感(PDF表格、图片文字提取后也能匹配);

- 核心短板:需要维护两种检索引擎(向量库+Elasticsearch)、权重调优需要经验(不同场景比例不同);

- 适用场景:多格式文档场景——包含PDF、表格、图片的混合知识库、用户习惯用关键词提问(如企业IT故障排查)、数据量10万-500万条。

4. 多模态RAG方案(多模态embedding+跨模态检索+结构化解析)

- 底层逻辑:支持文本、图片、表格、音频等多模态文档,用多模态embedding模型(如CLIP、BLIP)将不同类型数据转成统一向量,检索时支持跨模态匹配(比如用户问“这个产品的尺寸图”,能检索到相关图片并提取尺寸信息)。

- 核心优势:覆盖多模态知识、解决纯文本RAG的信息局限;

- 核心短板:多模态embedding模型训练成本高、检索速度比纯文本方案慢30%-50%、存储成本高;

- 适用场景:多模态知识场景——产品说明书(含图片+表格)、科研论文(含图表)、教育课件(含视频截图)、数据量<50万条(多模态数据存储成本高)。

5. RAG+微调混合方案(RAG补知识+微调提精度)

- 底层逻辑:RAG负责“广覆盖”(提供知识库长尾知识),微调负责“高精度”(优化大模型对检索结果的理解和生成逻辑)——先用RAG构建基础知识库,收集用户交互数据和未匹配的长尾问题,生成微调数据集,微调大模型后再与RAG融合。

- 核心优势:解决纯RAG的“生成质量低”“长尾问题匹配差”,端到端准确率比纯RAG高30%-40%;

- 核心短板:架构最复杂、开发周期长(1-2个月)、维护成本高(需持续更新微调数据集);

- 适用场景:高精度场景——医疗问答、法律检索、金融咨询、数据量>100万条、对答案准确率要求极高(>90%)。

实践步骤:从场景到落地,RAG选型的实操框架

选型的核心不是“选方案”,而是“先定义场景指标,再匹配方案”。以下是可直接套用的实操框架,分“场景分析→指标评估→方案落地→调优迭代”四步:

第一步:场景分析——明确你是“轻量场景”还是“大规模场景”

先通过3个核心问题给场景定性:

- 知识库数据量:≤10万条(轻量)、10万-100万条(中规模)、≥100万条(大规模);

- 并发需求:≤100 QPS(轻量)、100-500 QPS(中规模)、≥500 QPS(大规模);

- 核心诉求:优先成本(轻量)、优先召回率(中大规模)、优先多模态支持(特殊场景)、优先准确率(高精度场景)。

示例:某创业公司内部文档中心,数据量3万条,并发20 QPS,核心诉求是“低成本快速落地”——定性为“轻量场景”,匹配基础RAG方案。

第二步:指标评估——确定选型的核心约束条件

除了场景,还要评估4个关键指标,避免“过度设计”或“设计不足”:

- 响应时间:P95延迟要求(轻量场景<500ms,大规模场景<1s);

- 成本预算:服务器配置(轻量场景单台8核16G足够,大规模场景需集群)、存储成本(多模态数据存储成本是文本的3-5倍);

- 文档类型:纯文本(基础/增强方案)、混合格式(混合检索方案)、多模态(多模态方案);

- 准确率要求:普通场景(>80%)、高精度场景(>90%)。

第三步:方案落地——分场景的实操步骤(附代码/配置示例)

场景A:轻量场景(基础RAG方案)——以“个人知识库”为例

核心组件:文档处理(LangChain)+ embedding模型(sentence-transformers)+ 轻量级向量库(Chroma)+ 大模型(ChatGLM-6B)

实操步骤:

- 文档处理(语义分片优化,避免基础方案的割裂问题)

from langchain.text_splitter import RecursiveCharacterTextSplitter# 初始化语义分片工具,按字符长度+语义边界拆分

text_splitter = RecursiveCharacterTextSplitter(chunk_size=512, # 匹配embedding模型最大序列长度chunk_overlap=50, # 重叠部分避免语义割裂length_function=len,separators=["\n\n", "\n", ". ", " ", ""] # 按优先级拆分(段落→句子→短语)

)# 加载文档并分片

with open("personal_kb.txt", "r", encoding="utf-8") as f:doc = f.read()

chunks = text_splitter.split_text(doc)

print(f"拆分后文档片段数:{len(chunks)}")

- 向量库初始化与数据写入

from langchain.embeddings import SentenceTransformerEmbeddings

from langchain.vectorstores import Chroma# 初始化轻量embedding模型(平衡效果与速度)

embedding = SentenceTransformerEmbeddings(model_name="all-MiniLM-L6-v2")# 初始化Chroma向量库(本地文件存储,无需部署服务)

db = Chroma.from_texts(chunks,embedding,persist_directory="./chroma_db" # 本地存储路径

)

db.persist()

- 检索与生成融合

from langchain.chat_models import ChatGLM

from langchain.chains import RetrievalQA# 初始化本地大模型(避免API调用成本)

llm = ChatGLM(endpoint_url="http://localhost:8000", max_token=2048, temperature=0.1)# 构建检索链

qa_chain = RetrievalQA.from_chain_type(llm=llm,chain_type="stuff", # 简单拼接检索结果传给大模型retriever=db.as_retriever(search_kwargs={"k": 3}), # 检索Top-3相关片段return_source_documents=True # 返回来源文档,方便验证

)# 测试提问

query = "我之前记录的Python爬虫代理池搭建步骤是什么?"

result = qa_chain({"query": query})

print(f"答案:{result['result']}")

print(f"来源文档:{[doc.page_content for doc in result['source_documents']]}")

关键调优点:

- chunk_size:需匹配embedding模型的最大序列长度(all-MiniLM-L6-v2最大支持512),过大易导致embedding失真;

- search_kwargs={"k":3}:k值过大可能引入无关信息,过小可能遗漏关键信息,轻量场景k=3-5最优;

- temperature=0.1:降低大模型随机性,避免生成与检索结果无关的内容。

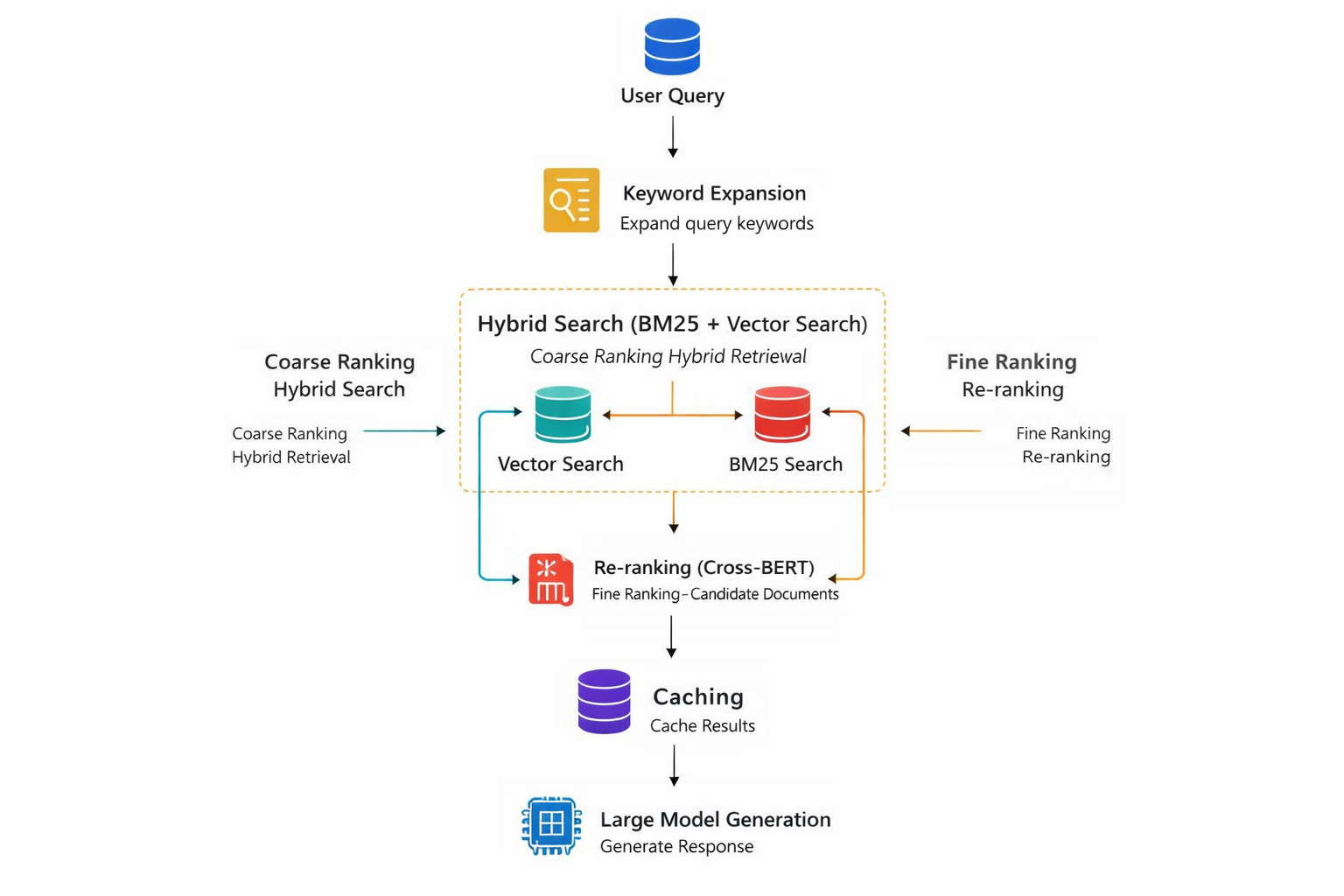

场景B:大规模场景(增强RAG+混合检索方案)——以“电商客服FAQ”为例

核心组件:文档处理(LangChain+LLM语义分片)+ 混合检索(Elasticsearch-BM25 + Milvus向量库)+ 检索重排(Cross-BERT)+ 大模型(GPT-4 Turbo)

实操步骤:

- 文档处理(LLM语义分片+结构化解析)

import json

from langchain.text_splitter import SemanticChunker

from langchain.llms import OpenAI# 用LLM做语义分片(精准匹配FAQ的问答逻辑,避免割裂)

llm = OpenAI(model_name="gpt-3.5-turbo", temperature=0)

text_splitter = SemanticChunker(llm=llm, chunk_size=1024)# 加载电商FAQ文档(结构化格式:问题+答案)

with open("ecommerce_faq.json", "r", encoding="utf-8") as f:faq_data = json.load(f)

docs = [f"问题:{item['question']}\n答案:{item['answer']}" for item in faq_data]

chunks = text_splitter.split_text("\n\n".join(docs))

- 混合检索引擎搭建(Elasticsearch+Milvus)

# 1. Elasticsearch-BM25初始化(关键词检索)

from elasticsearch import Elasticsearch

es = Elasticsearch("http://localhost:9200")# 创建索引并写入数据

index_name = "ecommerce_faq_bm25"

if not es.indices.exists(index=index_name):es.indices.create(index=index_name)

for i, chunk in enumerate(chunks):es.index(index=index_name, id=i, document={"content": chunk})# 2. Milvus向量库初始化(语义检索,集群部署支持大规模数据)

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

from langchain.embeddings import OpenAIEmbeddings# 连接Milvus集群

connections.connect("default", host="localhost", port="19530")# 定义Schema

fields = [FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=1536), # OpenAI embedding维度FieldSchema(name="content", dtype=DataType.VARCHAR, max_length=2048)

]

schema = CollectionSchema(fields=fields, description="ecommerce faq collection")

collection = Collection(name="ecommerce_faq_vector", schema=schema)# 创建索引(IVF_FLAT适合大规模数据精准检索)

index_params = {"metric_type": "L2", "index_type": "IVF_FLAT", "params": {"nlist": 1024}}

collection.create_index(field_name="embedding", index_params=index_params)# 写入向量数据

embedding = OpenAIEmbeddings()

embeddings = embedding.embed_documents(chunks)

entities = [embeddings, chunks]

collection.insert(entities)

collection.load()# 3. 混合检索逻辑(加权融合)

def hybrid_search(query, k=5):# BM25检索bm25_results = es.search(index=index_name,body={"query": {"match": {"content": query}}},size=k)bm25_docs = [(hit["_source"]["content"], hit["_score"]) for hit in bm25_results["hits"]["hits"]]# 向量检索query_embedding = embedding.embed_query(query)vector_results = collection.search(data=[query_embedding],anns_field="embedding",param={"metric_type": "L2", "offset": 0, "limit": k},output_fields=["content"])# 归一化向量检索分数(转为0-1区间)max_distance = max([res.distance for res in vector_results[0]]) if vector_results[0] else 1vector_docs = [(res.entity.get("content"), 1 - res.distance/max_distance) for res in vector_results[0]]# 加权融合(向量检索70%,BM25 30%)combined = {}for doc, score in bm25_docs:combined[doc] = combined.get(doc, 0) + score * 0.3for doc, score in vector_docs:combined[doc] = combined.get(doc, 0) + score * 0.7# 按分数排序,取Top-ksorted_docs = sorted(combined.items(), key=lambda x: x[1], reverse=True)[:k]return [doc for doc, score in sorted_docs]

- 检索重排(Cross-BERT优化相关性)

from sentence_transformers import CrossEncoder# 初始化重排模型(专门用于文本匹配排序)

cross_encoder = CrossEncoder('cross-encoder/ms-marco-MiniLM-L-6-v2', max_length=512)def rerank_docs(query, docs, top_k=3):# 构建(query, doc)匹配对pairs = [(query, doc) for doc in docs]# 计算相关性分数scores = cross_encoder.predict(pairs)# 按分数排序,取Top-ksorted_pairs = sorted(zip(docs, scores), key=lambda x: x[1], reverse=True)return [doc for doc, score in sorted_pairs[:top_k]]# 完整检索流程:混合检索→重排

query = "如何申请退货退款?需要哪些材料?"

retrieved_docs = hybrid_search(query, k=5)

reranked_docs = rerank_docs(query, retrieved_docs, top_k=3)

- 大模型生成与缓存优化(提升并发性能)

from langchain.chains import RetrievalQA

from langchain.cache import RedisCache

import redis

from langchain.llms import OpenAI# 缓存优化(减少重复检索,提升并发)

redis_client = redis.Redis(host='localhost', port=6379, db=0)

langchain.llm_cache = RedisCache(redis_client)# 初始化大模型

llm = OpenAI(model_name="gpt-4-turbo", temperature=0.1)# 构建生成链(refine模式优化答案质量)

qa_chain = RetrievalQA.from_chain_type(llm=llm,chain_type="refine",retriever=lambda q: rerank_docs(q, hybrid_search(q, k=5), top_k=3),return_source_documents=True

)# 测试大规模并发(可通过Locust模拟500 QPS)

result = qa_chain({"query": query})

print(f"答案:{result['result']}")

关键调优点:

- Milvus索引:大规模场景优先选IVF_FLAT(精准)或HNSW(高速),nlist参数建议设为数据量的平方根(如100万条数据设为1024);

- 混合检索权重:关键词密集型场景(如IT故障排查)可将BM25权重提至40%-50%;语义型场景(如产品咨询)保持向量检索70%权重;

- 缓存策略:热点问题(如“退货退款流程”)缓存生成结果,并发高峰时直接返回缓存,降低检索和生成压力。

如果觉得大规模场景的底层架构搭建(混合检索引擎、重排模块、集群部署)过于繁琐,可选择支持“一键部署增强RAG+混合检索”的在线平台,比如LLaMA-Factory online。它内置了Elasticsearch+Milvus混合检索、Cross-BERT重排、Redis缓存优化等核心模块,无需手动配置集群和调优参数,只需上传文档即可快速实现1000万条数据的RAG部署,P99响应时间稳定在500ms内,大幅降低大规模RAG的落地成本。

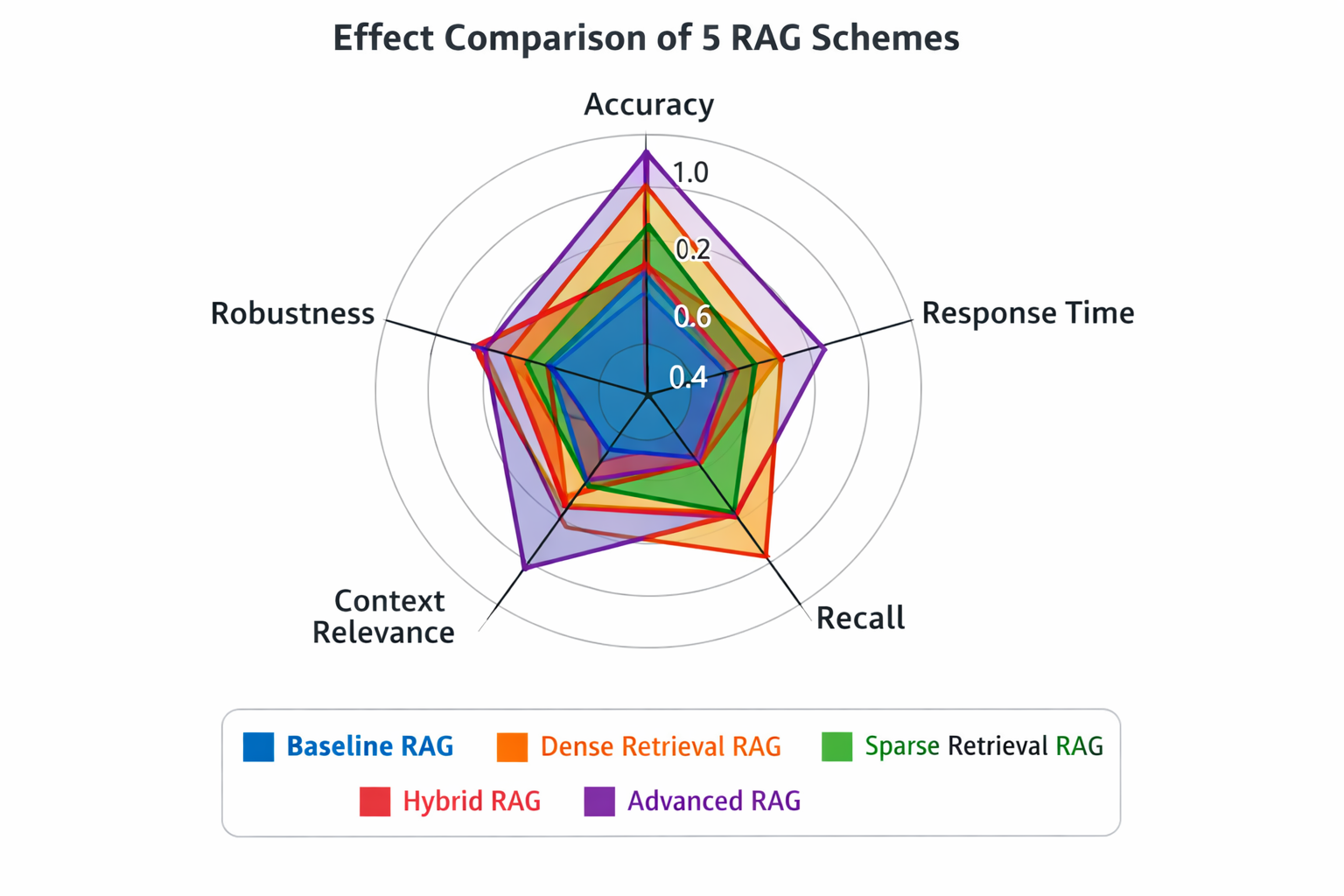

效果评估:如何验证选型方案是否达标?

选型落地后,需要从4个核心指标验证效果,避免“上线后才发现不达标”:

1. 核心评估指标

- 召回率(Recall@k):用测试集(100-200个真实用户提问+对应正确文档)评估,检索结果中包含正确文档的比例,轻量场景≥80%,大规模场景≥85%;

- 响应时间(P95/P99延迟):用Locust或JMeter模拟目标并发量,轻量场景P95<500ms,大规模场景P99<1s;

- 准确率(Answer Accuracy):人工标注测试集答案的准确率(是否符合知识库、无幻觉),普通场景≥85%,高精度场景≥90%;

- 成本指标:服务器CPU/内存使用率(峰值<80%)、存储成本(大规模场景每100万条文本存储成本<500元/月)。

2. 实操评估步骤

- 构建测试集:收集100-200个真实用户提问,手动标注每个提问对应的“正确文档片段”;

- 召回率测试:用测试集提问检索,统计每个提问的检索结果中包含正确文档的比例,计算平均召回率;

- 响应时间测试:模拟目标并发量(轻量100 QPS/大规模500 QPS),持续压测30分钟,记录P95/P99延迟;

- 准确率测试:人工审核测试集的生成答案,评估“是否准确、无幻觉、不遗漏关键信息”;

- 成本测试:监控压测期间的服务器资源使用率,核算月均成本,判断是否在预算范围内。

3. 调优迭代方法

如果某指标不达标,按以下方向优化:

- 召回率低:轻量场景→调整分片大小、更换更优embedding模型(如all-MiniLM-L6-v2→all-MiniLM-L12-v2);大规模场景→启用混合检索、优化重排模型;

- 响应时间长:轻量场景→更换更轻量向量库(Chroma→FAISS);大规模场景→提升缓存命中率、优化向量库索引(HNSW替代IVF_FLAT);

- 准确率低:优化大模型prompt模板(增加“基于检索结果生成,禁止编造信息”指令)、启用RAG+微调混合方案。

总结与科技的未来展望

RAG选型的核心逻辑可以总结为“三看”:看数据量、看并发量、看核心诉求——轻量场景选基础RAG,追求“低成本快速落地”;中大规模场景选增强RAG+混合检索,追求“高召回率+低延迟”;多模态场景选多模态RAG,追求“全类型知识覆盖”;高精度场景选RAG+微调混合方案,追求“极致准确率”。

回顾RAG技术的发展,从早期的基础方案到如今的增强RAG、多模态RAG,核心趋势是“更精准、更高效、更易用”——未来,RAG会与大模型深度融合(大模型内置检索能力,无需额外部署检索引擎)、隐私保护更完善(支持本地私有化部署+端到端加密)、自适应场景更智能(自动根据数据量和并发量调整架构)。

对于技术人员来说,选型的本质不是“追新”,而是“适配”——不需要盲目跟风复杂方案,也不能用轻量方案硬扛大规模场景。关键是掌握“场景-指标-方案”的匹配逻辑,同时善用成熟工具和平台,降低落地成本。

对于需要快速迭代不同RAG方案的团队(比如从轻量场景扩展到大规模场景,或从纯文本扩展到多模态),推荐选择支持“5种主流方案快速切换”的在线平台,LLaMA-Factory online能适配从1000条到1000万条数据的全场景,支持基础RAG、增强RAG、混合检索等方案的一键切换,无需重构底层架构,同时提供完整的效果评估工具(召回率测试、响应时间监控),帮助技术人员快速验证选型效果,加速RAG的落地与迭代。

最后,RAG选型没有“一劳永逸”的方案,需要根据业务发展持续优化——比如随着数据量增长,从基础RAG升级为增强RAG;随着用户需求变化,从纯文本RAG扩展为多模态RAG。希望这篇文章的选型框架和实操步骤,能帮你避开90%的坑,精准匹配适合自己场景的RAG方案。

今天这篇文章,基于10+企业级RAG落地经验,拆解5种主流RAG方案的底层逻辑、实测效果,给出“轻量场景(数据量<10万条,并发<100 QPS)”和“大规模场景(数据量>100万条,并发>500 QPS)”的选型框架与实操步骤,帮你精准避坑。

今天这篇文章,基于10+企业级RAG落地经验,拆解5种主流RAG方案的底层逻辑、实测效果,给出“轻量场景(数据量<10万条,并发<100 QPS)”和“大规模场景(数据量>100万条,并发>500 QPS)”的选型框架与实操步骤,帮你精准避坑。