Agentic RAG 是当前 LLM 应用中一个非常火热的方向。与传统 RAG 不同它让模型在推理过程中自主决定要不要检索、什么时候检索。这样就相当于给模型一套工具让它自己判断该用哪个。

目前训练 Agentic RAG 的主流做法是结果监督强化学习:只在推理结束后给一个标量奖励:对就是对、错就是错,而过程中完全没有任何反馈。

这种方式有几个明显的问题:

模型必须跑完整个推理链才能拿到分数,中途即使跑偏了也没法纠正;奖励信号极其稀疏,模型根本不知道哪些步骤有用、哪些是在浪费时间;而且单一的全局分数太粗糙了,没法告诉模型到底是哪个环节出了问题,想做细粒度优化几乎不可能。

DecEx-RAG 的核心思路

DecEx-RAG 把 RAG 建模成一个马尔可夫决策过程(MDP),分成决策和执行两个阶段。

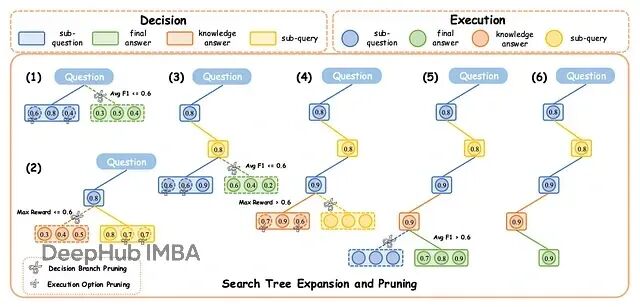

图1:DecEx-RAG 框架示意图,展示搜索树的扩展与剪枝过程

决策阶段解决两个问题:该停还是该继续?如果继续的话用内部知识还是去检索外部信息?每一步模型都要做出终止决策 σₜ 和检索决策 δₜ。

执行阶段关注的是生成质量。不管是子问题还是最终答案,都要求高质量输出。这个阶段用过程级奖励来优化。

而剪枝策略是 DecEx-RAG 的一大亮点:搜索树扩展太快会导致计算量爆炸所以需要动态剪枝,每一层做多次 rollout 模拟不同决策,把结果汇总成中间奖励;超过一半样本认为该停就停;如果内部知识生成的答案分数够高,直接跳过检索。

实测效果也是相当不错的,平均扩展时间从 743.2 秒压缩到 134.9 秒,快了将近 6 倍性能却几乎没有损失。

https://avoid.overfit.cn/post/7c93c6c1703f491e8d68f8156abecfef