增强 PyTorch 开发体验:容器化部署与文档表达的双重进化

在深度学习项目中,你是否经历过这样的场景?新成员加入团队,花三天才配好环境;线上训练报错“CUDA version mismatch”,却在本地无法复现;写完一篇技术博客后,读者反馈“内容扎实但读着太累”……这些问题的背后,其实并非模型设计之过,而是工程实践与知识传递方式的脱节。

真正高效的 AI 工程,不仅要求代码跑得通,更需要环境可复现、文档易理解、协作无摩擦。本文将从两个看似不相关的角度切入——一个是底层运行时的稳定性保障,另一个是上层表达的信息传达优化——揭示如何通过PyTorch-CUDA 容器镜像和Markdown 中 emoji 的语义增强技巧,共同构建一个“既能高效执行,又能清晰沟通”的现代 AI 开发闭环。

当你启动一个pytorch-cuda:v2.7镜像时,本质上是在调用一个已经被精心封装的深度学习宇宙:操作系统、Python 解释器、PyTorch 框架、CUDA 运行时、cuDNN 加速库、NCCL 多卡通信支持……所有组件都经过版本对齐和兼容性测试,就像一辆出厂即调校完毕的高性能赛车,只等你踩下油门。

这背后依赖的是 Docker 与 NVIDIA Container Toolkit 的协同机制。简单来说,Docker 提供了进程隔离和文件系统分层,而 NVIDIA 的工具链则打通了容器访问宿主机 GPU 的“最后一公里”。使用--gpus all参数后,容器内的 PyTorch 可以像宿主机程序一样直接调用 CUDA Runtime,进而将张量计算卸载到 GPU 上执行。整个流程对开发者透明,无需再为nvcc --version和torch.version.cuda是否匹配而焦头烂额。

举个实际例子:

docker run -it --gpus all \ -v $(pwd):/workspace \ -p 8888:8888 \ pytorch-cuda:v2.7 \ jupyter lab --ip=0.0.0.0 --allow-root --no-browser这一行命令完成了传统方式下数小时的工作:拉取环境、安装依赖、配置路径、启动 IDE。更重要的是,它保证了无论是在 MacBook 上的 M1 芯片(通过 Rosetta 模拟)、还是数据中心的 A100 集群,只要硬件支持,行为完全一致。这种一致性正是 MLOps 实践的基础。

这类镜像的价值远不止于“省时间”。在 CI/CD 流水线中,你可以用同一个镜像跑单元测试、模型训练和推理服务验证,避免“开发能跑,上线就崩”的尴尬。对于多节点训练任务,内置的 NCCL 支持也让DistributedDataParallel的初始化变得轻而易举——不再需要手动配置 hostfile 或 SSH 免密登录。

| 维度 | 传统源码安装 | 使用 PyTorch-CUDA 镜像 |

|---|---|---|

| 安装耗时 | 数十分钟至数小时 | 几分钟完成拉取与启动 |

| 版本控制难度 | 高(pip 冲突频发) | 极低(整体环境快照) |

| GPU 兼容性调试 | 手动匹配 CUDA/cuDNN 版本 | 由镜像维护者完成适配 |

| 团队协作效率 | 环境差异导致“玄学 bug” | 统一标准,新人一日上手 |

| 可复现性 | 弱(依赖隐式状态) | 强(镜像是不可变的事实) |

可以说,容器化不是“可选项”,而是现代 AI 工程化的基础设施标配。

然而,即使我们拥有了完美的运行环境,如果知识无法有效传递,依然会造成巨大的隐性成本。想象一下:一份没有格式区分的操作指南,警告信息淹没在段落中;新人面对满屏代码不知从何下手;关键配置步骤被当成注释跳过……这些都不是技术能力问题,而是表达效率的问题。

这时候,一个常被低估的工具开始显现其价值:emoji。

是的,就是那些看起来“不够严肃”的小图标。但在技术文档中合理使用 emoji,并非为了卖萌,而是一种基于认知心理学的微交互设计。人类大脑处理图像的速度远快于文字,尤其是在快速浏览长文档时,视觉标记能引导视线优先聚焦到关键区域。

比如:

⚠️CUDA 版本必须与 PyTorch 编译时版本严格匹配

✅建议做法:始终使用虚拟环境隔离项目依赖

🔧配置步骤:执行以下命令初始化容器环境

这些符号充当了“视觉锚点”,让不同类型的信息自然分组。它们不改变语义,但提升了信息的可扫描性(scannability)——这是高质量技术文档的核心指标之一。

GitHub、GitLab、Jupyter Notebook、VS Code、Typora 等主流平台均已原生支持 emoji 渲染,意味着你不需要额外插件即可获得收益。更重要的是,许多 emoji 已具备跨文化的共识意义:

- ❌ 表示失败或禁止

- 💡 表示提示或灵感

- 🔒 涉及安全或权限

- 📈 关联性能或增长

将它们融入 Markdown 文档,可以形成一套轻量级的“视觉语法”:

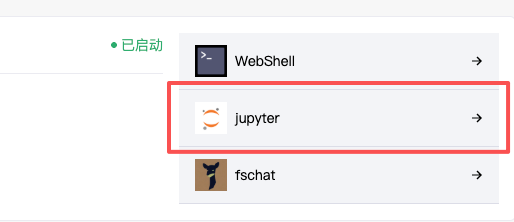

## 使用说明 ### 1、Jupyter 的使用方式 🖥️ 启动容器后,浏览器访问 `http://localhost:8888`,输入 token 登录 Jupyter Lab。 📌 **提示**:首次启动会生成 token,可在终端日志中查看。  ✅ 成功加载后,您可以在 notebook 中直接运行 PyTorch 代码并调用 GPU。 --- ### 2、SSH 的使用方式 🔐 若需远程连接开发环境,可通过 SSH 登录容器: ```bash ssh -p 2222 user@localhost⚠️ 注意:请确保容器已映射2222端口,并设置了用户认证。

在这个片段中,🖥️ 和 🔐 不仅标识了两种接入方式,还形成了心理上的分类槽(chunking),帮助读者建立结构化记忆。配合截图和代码块,整篇文档变成了一份“可视化操作手册”,显著降低了理解门槛。 --- 在一个典型的 AI 开发流程中,这两个技术实际上是协同工作的:+----------------------------+

| 用户交互层 |

| - Jupyter Notebook / Lab |

| - VS Code Remote-SSH |

| - CLI 命令行 |

+------------+---------------+

|

+------------v---------------+

| 应用运行时层 |

| - Python 解释器 |

| - PyTorch 框架 |

| - TorchVision, TorchText |

+------------+---------------+

|

+------------v---------------+

| GPU 加速支持层 |

| - CUDA Runtime |

| - cuDNN, NCCL |

| - NVIDIA Driver (Host) |

+------------+---------------+

|

+------------v---------------+

| 容器运行环境层 |

| - Docker Engine |

| - NVIDIA Container Toolkit|

| - PyTorch-CUDA-v2.7 镜像 |

+----------------------------+

```

而 Markdown + emoji 则作为“人机接口层”的一部分,帮助开发者快速理解各层之间的调用关系与操作路径。当新成员看到文档中的 🔧 图标就知道要准备动手,看到 🔴 就知道这里有高风险操作,这种非语言的提示极大地提升了信息传递效率。

一位算法工程师的典型工作流可能是这样的:

- 环境准备:一键拉起

pytorch-cuda:v2.7容器,挂载本地代码目录; - 开发接入:选择 Jupyter 或 SSH 进入,立即开始编码;

- 模型训练:编写脚本并调用

.to('cuda'),利用多卡并行加速; - 文档记录:将关键步骤整理成带 emoji 标记的 Markdown 文件;

- 团队共享:推送至 Git 仓库,成为可复现的知识资产。

这个过程之所以顺畅,正是因为技术和表达达成了统一:运行环境是确定的,文档表达是清晰的。

当然,在实践中也需要一些设计考量来避免滥用或误用。

首先是emoji 的使用尺度。虽然 😂 ❤️ 🎉 很有趣,但在正式文档中应避免情绪化或含义模糊的表情。推荐使用具有明确功能指向的符号,如:

- ✅ / ❌ 表示成功或失败

- ⚠️ / 🔴 表示警告或紧急事项

- 💡 / 📌 表示提示或重点

- 🔧 / 🛠️ 表示配置或调试

- 📊 / 📈 表示数据或性能

其次是镜像版本管理。建议采用清晰的命名规范,例如pytorch2.7-cuda12.1-python3.10,便于追溯依赖关系。同时定期更新基础镜像以包含安全补丁,防止因 OpenSSL 等底层库漏洞引发风险。

再者是文档与代码共存的最佳实践。将.md文件与源码放在同一仓库(如/docs目录),并通过 GitHub Pages 或 MkDocs 自动生成静态站点,使文档成为项目的一部分而非附属品。

最后别忘了安全设置:Jupyter 应启用 token 认证或密码保护,SSH 推荐使用密钥登录而非密码,防止未授权访问暴露敏感数据。

回到最初的问题:为什么我们要关心文档好不好读?

因为技术的终极目标不是“自己能跑通”,而是“别人也能复现”。在一个协作密集的研发环境中,可复现性 = 可传承性 = 工程成熟度。

PyTorch-CUDA 镜像解决了“运行时一致性”的问题,而 Markdown 中的 emoji 则提升了“认知效率”。前者确保机器执行无歧义,后者确保人类理解无障碍。这两者的结合,代表了一种新的工程思维:不仅要写出正确的代码,更要写出容易被理解和延续的知识。

未来,随着 AIGC 辅助写作的发展,我们可能会看到智能文档系统自动插入合适的 emoji、生成可视化流程图、甚至根据读者水平动态调整表述复杂度。但在此之前,掌握这种“技术+表达”的双重优化能力,已经是区分普通开发者与高效工程师的重要标志。

下次当你准备写一篇技术总结时,不妨试试在关键位置加一个 ✅ 或 ⚠️——那一点点颜色,可能就是别人顺利入门的第一束光。