本文 的 原文 地址

原始的内容,请参考 本文 的 原文 地址

本文 的 原文 地址

尼恩说在前面

年底,大厂的hc越来越多, 反而 机会越混越多。 以前的金九银十, 现在变成 黄金年底。

在45岁老架构师 尼恩的读者交流群(50+)中,最近有小伙伴拿到了一线互联网企业如阿里、滴滴、极兔、有赞、希音、百度、网易、美团的面试资格。

当然,这里提醒大家伙: 面试的之后, 把题目梳理好,一定 找尼恩来复盘。

前两天一个 小伙伴面 阿里,遇到的一个基础面试题:你们项目用了多线程吗? 怎么用的多线程?'

小伙伴只背过 threadpool的一些简单的八股文, 更没有背过 线程使用的10大雷区,也没有背过大厂低延迟场景,是如何配置线程池参数的?

所以, 临阵磨枪 有一句没一句的说了几嘴, 结果 挂了。回来后 ,小伙伴找尼恩复盘, 求助尼恩。这里尼恩给大家做一下系统化、体系化的梳理,梳理一个 《Java 多线程 学习圣经》按着尼恩的圣经, 大家可以充分展示一下大家雄厚的 “技术肌肉”,让面试官爱到 “不能自已、口水直流”。

也一并把这个题目以及参考答案,收入咱们的 《尼恩Java面试宝典PDF》V176版本,供后面的小伙伴参考,提升大家的 3高 架构、设计、开发水平。

所以,只能 临阵磨枪 有一句没一句的说了几嘴, 结果 挂了。

回来后 ,小伙伴找尼恩复盘, 求助尼恩。

这里尼恩给大家做一下系统化、体系化的梳理,使得大家可以充分展示一下大家雄厚的 “技术肌肉”,让面试官爱到 “不能自已、口水直流”。''

也一并把这个题目以及参考答案,收入咱们的 《尼恩Java面试宝典PDF》V176版本,供后面的小伙伴参考,提升大家的 3高 架构、设计、开发水平。

最新《尼恩 架构笔记》《尼恩高并发三部曲》《尼恩Java面试宝典》的PDF,请关注本公众号【技术自由圈】获取,后台回复:领电子书

Java多线程圣经:避开 多线程的10大雷区 ?释放 多线程 的 好处 , 碾压面试官

本文详细探讨了多线程的10大雷区:

雷区一:为啥要多线程? 之1 :单线程一旦 进入IO 等待, CPU就开始“摸鱼”

雷区二:为啥要多线程? 之2:单线程 让 多核server “一核冒烟,多核围观”

雷区三: 多线程一定比单线程快吗?

雷区4:别再手搓线程了!你以为的“简单并发”,其实是系统雪崩的导火索

雷区5: 线程池的核心参数(核心线程数、最大线程数、队列容量)是如何根据任务特性(如 CPU 密集型 / IO 密集型)设计的?有没有做过参数调优?

雷区6:线程池参数乱配 = 给系统埋雷!CPU 密集型配成 IO 型,服务直接雪崩

雷区7:线程池参数调优:IO 密集型任务为什么建议线程数设为 2N而不是2?

雷区8:听说过 Eager(急切)模式的线程池吗? 细致说说吧

雷区9: 线程池溢出:如果秒杀流量瞬间超过了线程池承载能力,会发生什么?

雷区10: 怎么排查一个“看似卡住”的多线程程序?

从核心概念、技术原理到实际应用进行全面解析。

雷区一:为啥要多线程? 之1: 单线程一旦 进入IO 等待, CPU就开始“摸鱼”

核心痛点:

单线程在执行 IO 操作时会陷入阻塞等待,导致 CPU 资源长时间空转,无法处理其他任务。这种“用高配机器干低效事”的现象,在现代多核服务器上尤为浪费,严重制约系统吞吐能力。

核心方案:

通过多线程并发模型,利用线程间的上下文切换机制,在一个线程等待 IO 时调度其他就绪线程使用 CPU,实现 CPU 时间片的高效复用,最大化提升系统整体处理效率。

火坑:单线程下的“带薪假”

想象这样一个场景:你雇了一个员工去送10份文件,但他每次只能送一份,而且每送到一处就要等对方签收(类似网络响应),期间他站在原地不动。虽然他在“岗”,却几乎不干活 —— 这就是单线程面对 IO 阻塞的真实写照。

在典型的互联网应用中,比如电商下单、用户登录、查询缓存、调用支付接口等操作,90%以上都是 混合型任务。

它们的特点是:

- 大量时间花在数据库读写或外部服务响应上;

- 真正占用 CPU 计算的时间极短。

如果用单线程串行处理这些请求,每当发起一次数据库查询或远程调用,程序就会暂停,CPU 只能“陪等”。这段时间本可以处理成百上千个其他请求,却被白白浪费。

这就是所谓的 “CPU 空洞” —— 看似系统在运行,实则算力闲置,性能瓶颈根本不在硬件,而在编程模型。

解决之道:让 CPU 忙起来

要解决这个问题,关键是 别让 CPU 闲着。

操作系统支持多线程并发执行,当某个线程因 IO 阻塞暂停时,系统可以快速切换到另一个就绪线程继续执行 —— 这个过程叫做 上下文切换。

核心机制:分时复用 + 上下文切换

- 当线程 A 发起 IO 请求后进入阻塞状态;

- 操作系统立即将 CPU 控制权交给线程 B;

- 线程 B 执行自己的任务,可能也在某刻阻塞;

- 再切回线程 A 或调度线程 C……

- 如此往复,让 CPU 始终有活可干。

虽然切换本身有一定开销(保存/恢复寄存器状态),但相比动辄几十甚至几百毫秒的 IO 等待时间,这点代价完全可以忽略不计。

总结

- 单线程在 IO 场景下会造成严重的 CPU 资源浪费;

- 多线程通过 上下文切换 实现时间片复用,有效填补 IO 等待间隙;

- 使用 线程池 是最佳实践,尤其对 IO 密集型任务应适当增大线程数量;

- 合理配置线程池参数,才能既榨干硬件性能,又避免资源失控。

记住一句话:不要让昂贵的 CPU 在那里“摸鱼”——它本可以同时处理成百上千个等待中的请求。

雷区二:为啥要多线程? 之2:单线程让多核服务器“一核冒烟,多核围观”

核心痛点:计算资源严重浪费

现代服务器普遍配备多核CPU(如16核、32核),但若程序采用单线程执行模式,仅能利用一个物理核心,其余核心处于闲置状态。

面对大批量计算任务(如订单对账、规则校验等),系统吞吐量被单核性能牢牢限制,造成“一核满载冒烟,十五核围观吃瓜”的尴尬局面,硬件投资回报率极低。

核心方案:任务并行化 + 多核映射

将大计算任务拆分为多个可独立执行的子任务,通过并行框架(如 ForkJoinPool 或 ParallelStream)调度到不同CPU核心上同时运行,实现“群攻”式处理,最大化发挥多核算力,显著提升整体处理速度与系统吞吐能力。

火坑:单线程的“一根筋”执行

在高配服务器上跑单线程程序,就像开着法拉利却只用一档爬坡——白白浪费性能。

例如,在秒杀活动结束后需要批量处理数百万笔订单进行财务核算或风控校验。如果使用单线程逐条处理:

- 该线程只能绑定在一个CPU核心上运行;

- 单个核心很快达到100%负载,开始“冒烟”;

- 其他15个甚至更多核心却全程“围观”,毫无作为;

- 整体处理时间取决于单核运算能力,无法随硬件升级而缩短。

这不仅拖慢业务响应,还导致服务器资源利用率极低,成本效益严重失衡。

解决之道:从“单打”到“群攻”

要真正释放多核潜力,必须打破单线程思维定式,转向并行计算模型。

关键逻辑:

1、Fork(拆分):把大任务分解为多个可并行的小任务;

2、Execute in Parallel(并行执行):由运行时自动分配到空闲CPU核心上并发运行;

3、Join(合并):汇总各子任务结果,完成最终输出。

这种方式实现了真正的并行(Parallelism),而非仅仅是并发(Concurrency),直接将处理能力与核心数量挂钩。

雷区三: 多线程一定比单线程快吗?

面试官潜台词:“你是否知道多线程的成本?别把并发当银弹。”

核心痛点:盲目使用多线程反而拖慢系统性能.

核心原因在于:线程上下文切换的开销和资源竞争的放大效应,在任务粒度小、CPU密集或锁争用严重时,多线程不仅无法提速,还会显著增加系统负担。

核心方案:按任务类型科学设计线程数

IO密集型/混合型任务通过多线程提升CPU利用率,CPU密集型任务则控制线程数匹配硬件核心数,避免过度并发,辅以线程池与无锁结构优化开销。

一、为什么多线程可能更慢?——线程上下文切换的代价

多线程并不等于“更快”。

当操作系统在多个线程之间切换执行时,必须保存当前线程的运行状态(如寄存器、程序计数器、栈信息),再加载下一个线程的状态,这个过程称为上下文切换。

关键点:

- 每次切换耗时 几微秒到几十微秒,虽短但累积频繁则成大患。

- 切换期间 CPU 不执行任何业务逻辑,纯属系统开销。

- 频繁切换还会导致 CPU 缓存失效(Cache Miss),进一步降低执行效率。

结论:如果线程太多、任务太短,CPU 反而忙于“调度”,而不是“干活”。

二、什么情况下多线程反而更慢?

场景 1:CPU 密集型任务 + 线程数 > CPU 核心数

示例:在 8 核服务器上启动 32 个线程进行图像编码。

问题:所有线程都在抢 CPU,无法真正并行,反而因频繁切换导致整体变慢。

结果:吞吐下降,延迟上升,资源浪费。

场景 2:任务粒度过小

示例:每个任务只做一次简单计算(耗时 1μs),却用线程池提交。

问题:线程创建、调度、切换成本远高于任务本身。

结果:得不偿失,性能负增长。

场景 3:锁竞争激烈

示例:多个线程同时写入同一个 synchronized 方法或共享变量。

问题:多数线程处于阻塞/唤醒状态,实际并发度低。

结果:上下文切换激增,CPU 花费大量时间在“排队”而非“执行”。

场景 4:单核环境无 IO 等待

说明:没有多核支持,并行无从谈起;若无 IO 阻塞,线程无法让出 CPU。

结果:多线程只能轮流执行,额外增加调度负担。

三、什么时候多线程才更快?

| 场景 | 加速原理 |

|---|---|

| IO 密集型任务 (如网络调用、数据库查询、文件读写) |

线程等待 IO 时主动让出 CPU,其他线程可继续执行 → 提高 CPU 利用率 |

| CPU 密集型任务 + 多核环境 (线程数 ≈ CPU 核心数) |

实现真正并行计算 → 缩短总耗时 |

| 高并发请求处理 (如 Web 服务、API 接口) |

异步响应用户请求,提升系统吞吐与响应速度 |

关键洞察:

多线程的价值不是“多”,而是“巧”——

-

掩盖 I/O 延迟,不让 CPU “空等”;

-

发挥多核算力,让任务真正“并行”。

雷区4:手搓 new Thread() “非常简单”,但是是系统雪崩的导火索

核心痛点:节制手搓 new Thread() 创建线程导致资源失控与系统不可用。

每次 new Thread() 都会真实创建操作系统级线程,消耗大量内存(默认约1MB栈空间)和CPU调度资源。在高并发场景下,线程数量爆炸式增长,轻则频繁GC、CPU打满,重则直接触发 OutOfMemoryError,导致服务宕机。更严重的是,这种模式完全无法限制并发量,一旦下游响应变慢,任务堆积将引发连锁故障。

核心方案:统一使用显式配置的 ThreadPoolExecutor 线程池进行线程管理。

通过线程复用、有界队列缓冲、最大并发控制和拒绝策略兜底,实现对系统资源的可控调度。既能提升性能,又能防止流量洪峰压垮服务,是生产环境唯一可靠的多线程实现方式。

关键认知:线程不是免费的——它是昂贵的操作系统资源,必须像数据库连接一样被池化管理。

为什么 new Thread() 是致命陷阱?

问题一:线程爆炸,内存迅速耗尽

每个 Java 线程对应一个 OS 线程,默认占用 1MB 栈内存。

假设每请求启动一个线程,QPS 达到 1000 → 至少 1GB 内存被线程独占,还未计算堆中对象开销。

实际后果:java.lang.OutOfMemoryError: unable to create new native thread,系统彻底瘫痪。

问题二:并发无上限,系统失去保护能力

没有任何限流机制,线程数随请求数线性增长。

当数据库或远程接口变慢时,线程阻塞不释放,新请求持续涌入 → 线程池化前的“自由创建”等于主动放弃熔断降级能力。

问题三:性能反而下降

创建/销毁线程的成本远高于执行短任务本身。

大量 CPU 时间浪费在上下文切换上,实际用于业务处理的时间大幅缩水。

为什么 Runnable 不是解决方案?

很多人误以为:“我用了 Runnable 接口,就规范了!”

但如果你这样写:

new Thread(myRunnable).start(); // 本质仍是 new Thread()那只是披着接口外衣的手动创建线程,所有资源问题依旧存在。

正确认知:

- Runnable 只是一个任务定义接口,描述“做什么”。

- 它不解决“谁来执行”、“如何调度”、“并发多少”等问题。

- 要发挥其价值,必须配合线程池使用。

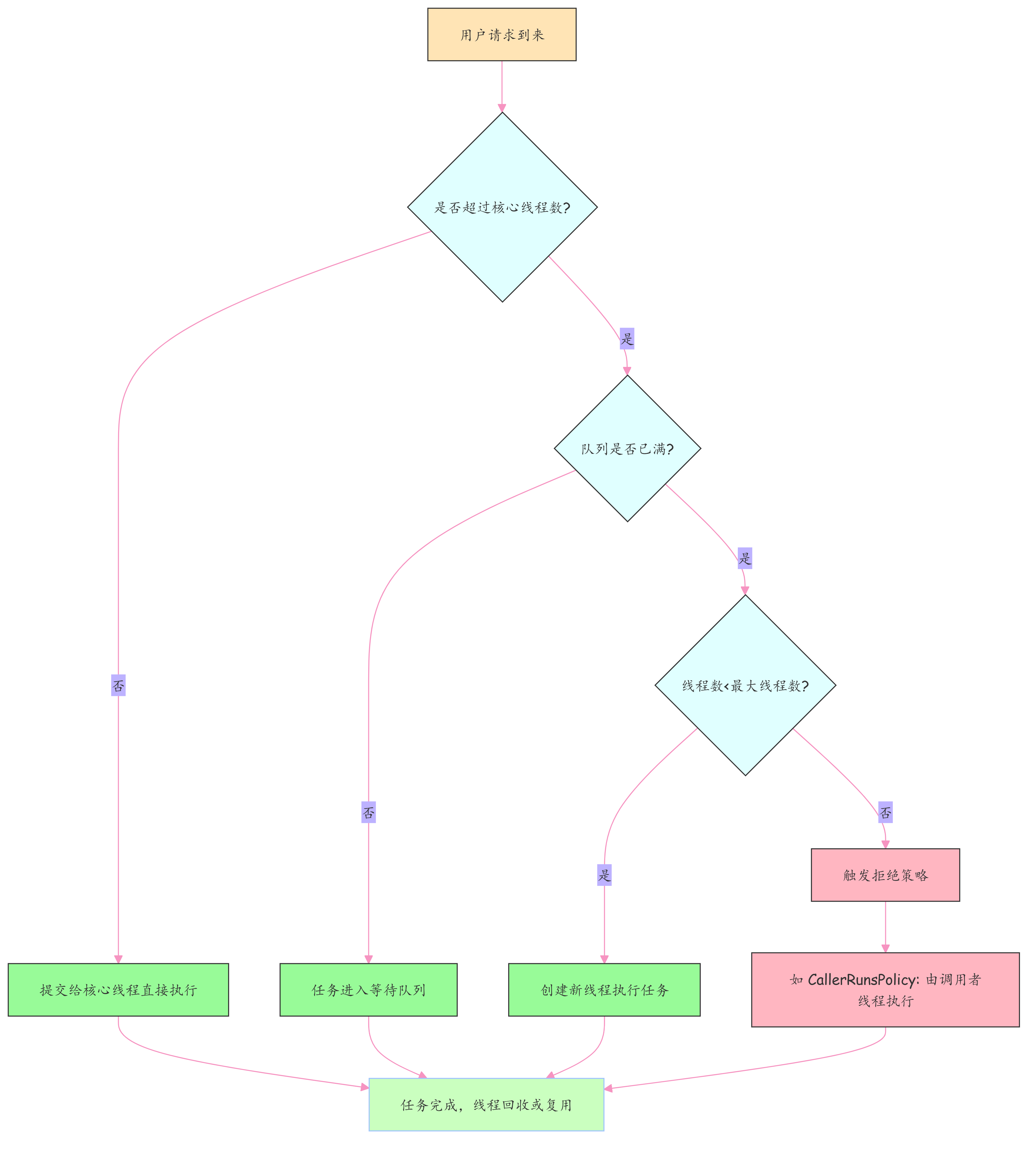

正确实践:自定义 ThreadPoolExecutor

ThreadPoolExecutor executor = new ThreadPoolExecutor(4, // 核心线程数:常驻工作线程16, // 最大线程数:突发负载可扩容至此60L, // 空闲线程存活时间TimeUnit.SECONDS,new ArrayBlockingQueue<>(50), // 有界队列:最多排队50个任务new ThreadFactoryBuilder().setNameFormat("order-pool-%d").build(), // 命名规范,便于排查new ThreadPoolExecutor.CallerRunsPolicy() // 拒绝策略:由调用线程执行,减缓流入速度

);线程池解决了哪些核心问题?

| 传统问题 | 线程池解决方案 |

|---|---|

| 资源爆炸 | 线程复用 + 并发上限控制 |

| 任务积压失控 | 有界队列 + 拒绝策略兜底 |

| 难以监控 | 提供运行指标:活跃线程数、队列长度等 |

| 配置黑盒 | 所有参数显式可控,支持按业务调优 |

️ 重要警告:避免使用 Executors.newFixedThreadPool() 等工具类创建线程池!

其内部使用 LinkedBlockingQueue 且默认容量为 Integer.MAX_VALUE,相当于无界队列,任务只进不出 → 内存迟早耗尽!

总结:选对工具,才能稳如泰山

| 使用方式 | 是否推荐 | 原因说明 |

|---|---|---|

| new Thread() | 绝对禁止 | 资源不可控,极易引发系统崩溃 |

| Runnable + Thread | 伪解决方案 | 本质仍是手动创建,风险未解除 |

| 自定义 ThreadPoolExecutor | 生产唯一推荐 | 资源可控、性能优越、可观测、可防御 |

记住一句话:多线程的关键不在“能跑”,而在“稳得住”。

用好线程池,才是构建高可用系统的真正起点。

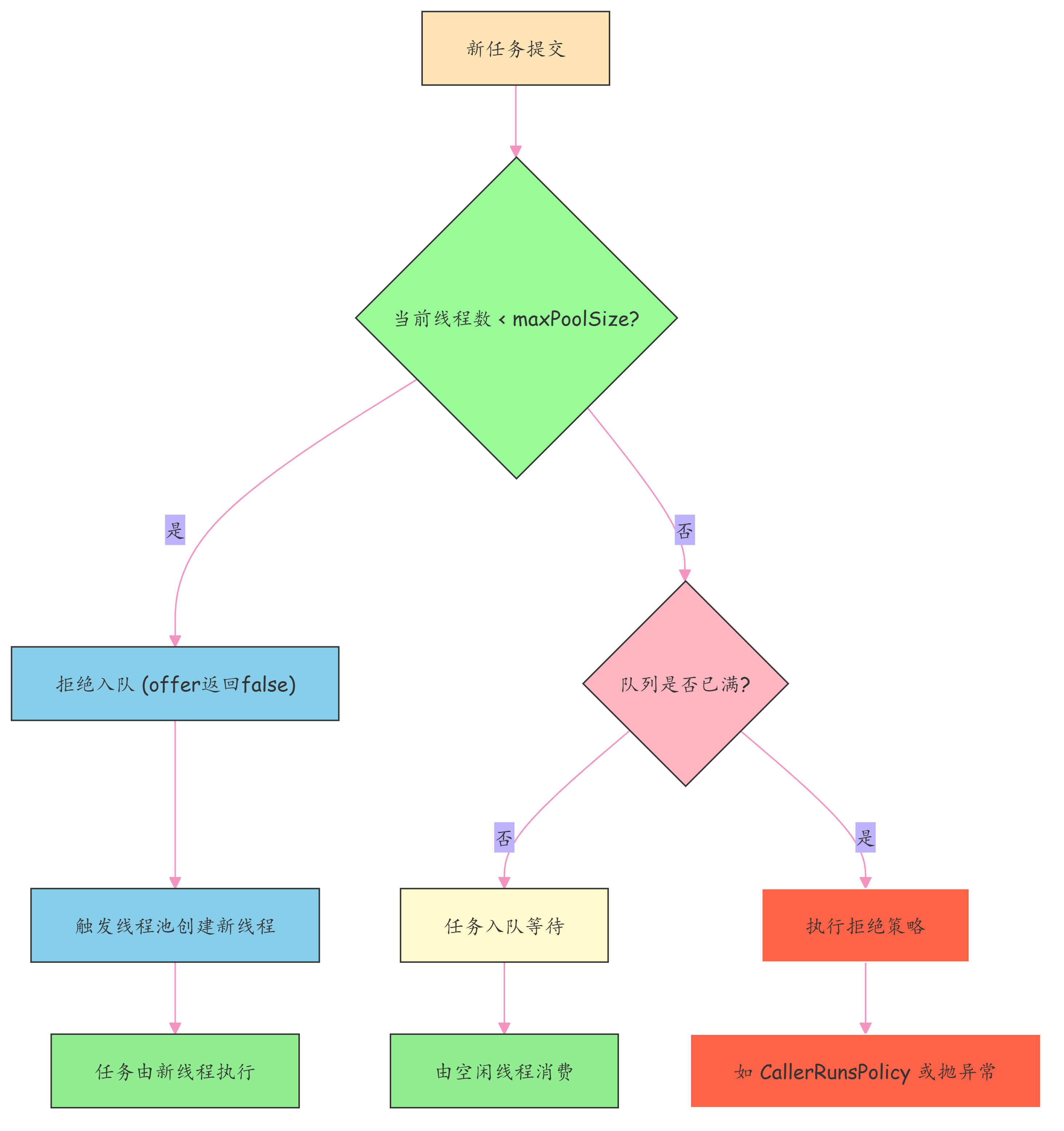

核心流程图解

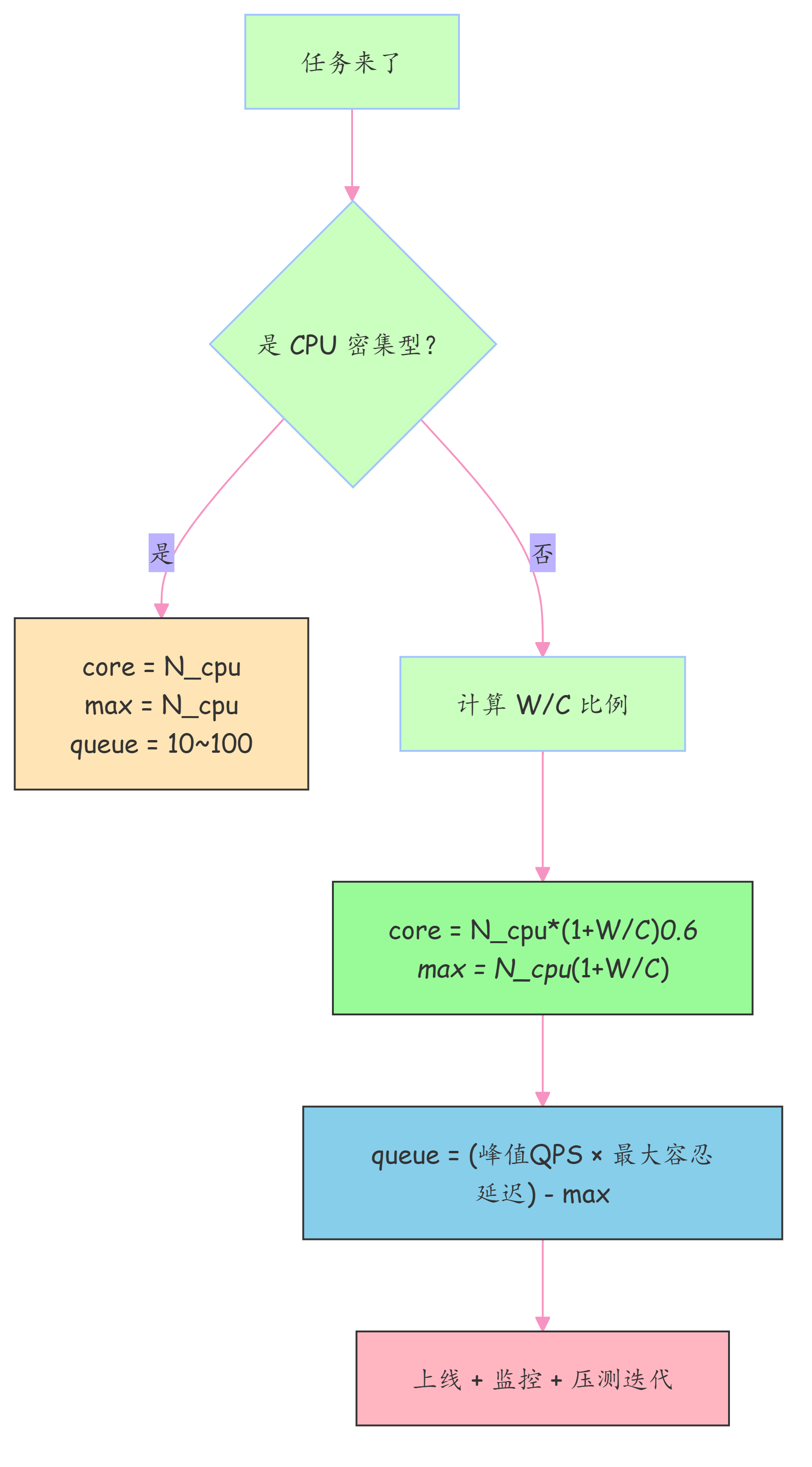

雷区5:线程池的核心参数(核心线程数、最大线程数、队列容量)是如何根据任务特性(如 CPU 密集型 / IO 密集型)设计的?有没有做过参数调优?

线程池这玩意儿就像个工厂流水线,工人(线程)太少活干不完,太多又挤成一团,一分一秒都耗不起。

所以,你得知道活是“动手快”还是“光等着”,才能决定请多少人、排多长队。

要不然,不是机器闲着,就是任务堆成山,系统一压就崩。

一、算 maximumPoolSize 最大线程数

先看任务类型:CPU 密集型/IO 密集型任务/混合型任务

1. CPU 密集型任务 ”

- 特点:一直算,不等别人,比如加密、图像处理。

- 线程数 ≈ CPU 核数(或 +1)

若任务完全无阻塞(纯计算),直接配置为CPU核心数即可;

若有极少量阻塞,+1 更稳妥。

原理:CPU 核心数是并行计算的最大 “硬件上限”,+1 是为了应对线程偶尔的阻塞(如缺页中断),避免 CPU 空闲;

2 IO 密集型任务

一般来说,网络/磁盘 IO 等待时 CPU 是空闲的,但是,两倍核数可把 CPU 利用率拉满。

所以, Netty 默认搞个 “2N” , 但是这个是经验起步值。

这里是netty的默认 设置。 尼恩教科书《Java高并发核心编程卷2》建议IO密集型设为 2N 。

Netty 的 I/O 密集型有一个假设, “等待时间远=计算时间” , 如果 “等待时间 不等于 计算时间” ,那么netty的 “2N” 需要用公式重新计算。

IO 密集型任务 属于 混合型任务 的一种细分类型。 真要计算 的话,得拿 下面的 混合型任务 公式算。

尼恩提示: Netty 线程池 “2N” 是经验值而非固定值,且完全符合 “线程数 = CPU 核心数 ×(1 + 等待时间 / 计算时间)” 的核心公式 。

3. 混合型任务

特点:发个请求,然后干瞪眼等响应,比如调接口、查数据库。

尼恩教科书《Java高并发核心编程卷2》 理想公式:

N_threads = N_cpu * (1 + W/C)- W:等的时间(比如数据库查询 耗时 280ms)

- C:自己干活的时间(比如解析数据 20ms)

- W/C = 14 → 要 4×(1+14)=60 个线程才吃得饱

二:算 队列容量

黄金公式

队列容量 = (峰值 QPS - 线程池每秒能处理的任务数) * 最大容忍延迟 这个公式是对线程池容量规划的动态建模。 可以把这个公式拆解为:每s多出来的任务量 × 允许堆积的时间。

A. (峰值 QPS - 线程池每s能处理的任务数)

这部分计算的是“净积压速度”。

- 峰值 QPS:是任务“产生”的速度(生产者)。

- 线程池每秒处理数:是任务“消耗”的速度(消费者)。线程池每秒处理数 = maxPoolSize / 单个任务平均耗时(秒)。

- 两者的差值:就是每秒钟处理不掉、被迫必须塞进队列的任务数量。

B. 最大容忍延迟

这部分代表了“缓冲时间”。 指的是一个任务在队列里排队最长能等多久。如果超过这个时间,业务可能就超时了,或者用户就流失了。

举例说明:

想象你在经营一个超市收银台:

1、峰值 QPS:每秒钟有 10 个人 来排队结账。

2、线程池处理能力:收银员每秒只能给 6 个人 结账。

3、净积压:每过 1 秒,队伍里就会多出 4 个人(10 - 6 = 4)。

4、容忍延迟:顾客脾气很差,排队超过 5 秒 就会弃购走人。

队列容量(水池深度)应该是多少? 为了让这 5 秒内来的顾客都不走,你需要准备的排队位子就是:

(10 - 6) × 5 = 20 个位子 如果你准备了 100 个位子(队列过大),最后一个人虽然能排进去,但他前面有 99 个人,他得等 10 多秒,早就超过 5 秒的容忍度了。

如果你只准备了 5 个位子(队列过小),收银员还在忙,后面的人想排也排不进来,直接就被“拒绝”了。

如果任务处理很快,新公式算出来的队列容量会更小、更科学。因为它意识到线程在等待时间内是可以“跑好几趟”的。

三、真实案例:支付回调延迟从 5s 干到 0.4s

场景背景

- 任务:调第三方支付接口(平均 300ms,其中 280ms 在等)

- 机器:4 核 CPU,8G 内存

- SLA:最大容忍延迟 < 1s

- 计算得:W/C ≈ 14 → 理论需 60 线程

初始配置(太保守,翻车了)

corePoolSize = 10

maxPoolSize = 30

queueCapacity = 100 // 太大,任务排队到天荒地老结果:高峰期积压严重,延迟飙到 5s+

配置优化

基于 的尼恩《Java高并发核心编程》中的方法论,我们来为这个支付回调场景进行一次深度建模计算。

1. 计算 maximumPoolSize (最大线程数)

根据混合型任务公式:

N_threads = N_cpu * (1 + W/C)- W:等的时间

- C:自己干活的时间

已知条件:

- N_cpu= 4 (4 核机器)

- 总耗时 = 300 ms

- 等待时间 W = 280 ms (调接口等待)

- 计算时间 C = 20 ms (总耗时 300 ms - 280 ms )

代入公式:

- W/C =14

- N_threads= 4 * (1 + 14) = 60

结论: 为了把这 4 核 CPU 的利用率拉满,不让它在等待 IO 时闲着,我们需要配置 maxPoolSize = 60 。

2. 计算“线程池每秒能处理的任务数” (吞吐能力)

在算队列之前,先看这 60 个线程火力全开时,一秒钟能消化多少回调请求。

- 单个线程每秒处理数: 1s/300ms=3.33

- 整个线程池每秒处理数: 60*3.33 约200个任务

3. 计算 workQueue 容量 (队列深度)

假设该场景面临的峰值 QPS 为 400(此时流量已经超过了线程池的处理能力 200)。

SLA 要求:最大容忍延迟 < 1s。

黄金公式:队列容量 = (峰值 QPS - 线程池每秒能处理的任务数) * 最大容忍延迟

代入数据:

- 净积压速度 = 400 - 200 = 200 个/秒

- 容忍时间 = 1s

- 队列容量 = 200 * 1 = 200

结论: 队列容量应设为 200。

4. 验证与最终配置建议

| 参数 | 配置值 | 理由 |

|---|---|---|

| corePoolSize | 60 | 考虑到支付回调通常是瞬时高并发,核心线程可直接与最大线程一致。 高并发不多的场景,可以设置为 maximumPoolSize 的60%到80% |

| maximumPoolSize | 60 | 基于 尼恩的黄金 理论计算,平衡 4 核 CPU 的 IO 等待。 |

| workQueue | LinkedBlockingQueue(200) | 保证在 1s 延迟内,能缓冲 2 倍于处理能力的瞬时峰值。 |

| RejectedPolicy | CallerRunsPolicy | 支付回调不能丢,若队列也满了,让 Tomcat 线程自己去执行,起到降速限流作用。 |

四、通用建议:别再犯低级错误

1、 禁用无界队列

LinkedBlockingQueue() 默认是 Integer.MAX_VALUE,内存爆了都不知道咋爆的。

2、 允许核心线程超时(流量波动大时特别香)

threadPool.allowCoreThreadTimeOut(true);3、 参数要能动态改

接 Apollo / Nacos,改个数不用重启服务,线上救命神器。

可以参考尼恩团队第 54章视频中的动态线程池。

4、 监控必须上

- 暴露指标:活跃线程、队列大小、完成任务数

- 结合 SkyWalking / Prometheus + Grafana 告警

五、决策流程图:照着走,不出错

尼恩说:没有万能配置,只有持续观察+微调,才是王道。

别信“别人家的参数”,你家的业务,得你自己算明白。

六、总结一句话

线程池不是随便一设就完事的,它是你系统的“调度大脑”。

任务类型不清,参数乱配,轻则延迟高,重则服务挂。

记住:算清楚再开线程,控好队列防爆炸,配上监控能救命。

雷区6: CPU 密集型配成 IO 型/混合型,服务直接雪崩,怎么办?

核心痛点:线程资源配置与任务特性严重错配,导致系统性能断崖式下跌甚至崩溃。

无论是 CPU 密集型任务开了过多线程引发频繁上下文切换,还是 IO 密集型任务线程不足造成请求堆积,亦或是使用无界队列导致内存溢出,本质上都是“盲目配置”带来的资源失控。

核心方案:以任务类型为依据,通过公式驱动 + 有界控制 + 实时监控,实现线程池参数的科学配置与动态调优。

拒绝拍脑袋,用 N_cpu 和 W/C 比值量化需求,结合有界队列和拒绝策略兜底,确保系统稳定高效运行。

火坑现场:参数乱配的三大典型灾难

火坑 1:CPU 密集型任务开启高并发线程

场景:图像压缩、视频编码等纯计算服务

错误配置:8核机器上设置 core=32, max=64

后果:大量线程争抢 CPU,上下文切换开销飙升,系统态 CPU(sys%)高达 40%,实际吞吐下降超 60%

本质问题:线程数远超 CPU 核心数,只会增加调度负担,无法提升并行能力

火坑 2:混合型任务线程数严重不足

场景:支付回调处理,平均耗时 300ms,其中 280ms 为网络等待

错误配置:core=4, max=8, queue=200

后果:高峰期任务积压,队列打满,P99 延迟从 200ms 暴涨至 8s,用户投诉激增

讽刺现实:CPU 利用率不到 30%,明明资源闲置,却因线程不够让请求干等!

火坑 3:无界队列 + 大量线程 = 内存炸弹

错误配置:使用 newCachedThreadPool() 或默认容量的 LinkedBlockingQueue

触发条件:下游数据库变慢 → 任务处理延迟 → 新任务持续涌入

后果:队列无限增长,堆外内存耗尽,抛出 OutOfMemoryError: Direct buffer memory,JVM 崩溃

️ 血泪教训:这是大厂生产环境中高频出现的致命事故之一

大厂实战解法:三步精准配置法

第一步:识别任务类型(定性)

准确判断任务属于哪一类,是科学配置的前提:

| 类型 | 特征 | 典型示例 |

|---|---|---|

| CPU 密集型 | 主要消耗 CPU 资源,几乎无 I/O 等待 | 加密解密、数据压缩、数学运算 |

| IO 密集型 / 混合型 | 大部分时间在等待网络、磁盘、DB 返回 | HTTP 调用、数据库查询、文件读写 |

提示:绝大多数业务系统属于“混合型”,不能简单归为 CPU 或 IO 密集型。

第二步:科学计算线程数(定量)

CPU 密集型任务的黄金公式

corePoolSize = maxPoolSize = N_cpu (或 N_cpu + 1)原理:线程数略大于核心数即可充分利用 CPU,避免多余线程带来调度开销。

IO 密集型 / 混合型任务黄金公式 估算理论最优线程数:

最佳线程数 ≈ N_cpu × (1 + W/C)-

N_cpu:CPU 核心数

-

W:平均等待时间(如远程调用响应时间)

-

C:平均 CPU 计算时间(真正占用 CPU 的时间)

示例:8 核机器,某接口 W=280ms, C=20ms → W/C = 14 → 理论线程数 = 8 × (1+14) = 120

实际可设 core=60~80, max=100~120,留出弹性空间。

关于 Netty 的 “2N” 规则?

Netty 默认使用 2 * CPU 是基于本地通信场景的经验值(W ≈ C)。一旦涉及远程调用(W >> C),必须重新测算,切忌生搬硬套。

第三步:有界控制 + 拒绝兜底(防爆)

-

队列必须有界:优先使用 ArrayBlockingQueue,容量建议 50~200

黄金公式:队列容量 = (峰值 QPS - 线程池每秒能处理的任务数) * 最大容忍延迟

-

拒绝策略推荐:CallerRunsPolicy

当线程池饱和时,由提交任务的线程自己执行任务,起到自然限流作用,防止雪崩。

-

附加建议:

- 开启核心线程超时:allowCoreThreadTimeOut(true)(适用于流量波动大的服务)

- 参数外部化:通过 Nacos/Apollo 动态调整,无需重启应用

- 必须接入监控:活跃线程数、队列大小、拒绝次数、任务执行时长等关键指标

雷区7:IO 密集型任务(如netty )为什么 线程数设为 2N ?

摒弃“2N”教条,采用科学公式 线程数 = CPU核心数 × (1 + 等待时间 / 计算时间) 动态计算最优值,并结合系统资源上限(内存、句柄、上下文切换成本)进行工程折衷,实现吞吐最大化与稳定性平衡。

很多开发者记住了这样一句话: “IO密集型任务,线程数配成 2×CPU核数 就够了。”

于是无论面对的是毫秒级的Redis访问,还是秒级的远程API调用,统统配置为 corePoolSize=16(在8核机器上)。

结果呢?—— 系统明明有算力,却“卡”在等待上。

- 慢接口耗时2秒,其中1990ms是网络+外部处理,本地逻辑仅10ms;

- 16个线程最多并发处理16个请求,每2秒完成一轮 → 实际QPS只有8;

- 来了50QPS?剩下42个只能排队,P99延迟从几百毫秒暴涨到几十秒;

- 更讽刺的是:CPU利用率不到20% —— 算力闲置,线程却不够!

这不是性能瓶颈,这是资源配置错误。

大厂实战解法:用公式说话,动态适配

第一步:测量真实等待时间 W 和计算时间 C

使用APM工具(如SkyWalking、Prometheus + 自定义埋点)统计:

- 总耗时 T = 请求开始到结束的时间

- 计算时间 C = 纯CPU执行时间(不含I/O,如数据解析、规则判断)

- 等待时间 W = T - C

示例场景:订单风控服务调用征信系统

- 总耗时 T = 2000ms

- 本地逻辑执行 C = 10ms(JSON解析 + 规则校验)

→ W = 1990ms,W/C = 199

第二步:代入公式计算理论线程数

根据经典并发模型公式:

$$

线程数 = N_{cpu} \times \left(1 + \frac{W}{C}\right)

$$

代入数值:

$$

线程数 = 8 \times (1 + 199) = 1600

$$

这意味着:理论上需要约 1600个线程 才能充分填满CPU的空闲间隙,在等待期间持续处理新任务。

第三步:结合资源限制做工程折衷

虽然理论值是1600,但需考虑现实约束:

- 每个线程默认栈大小1MB → 1600线程 ≈ 1.6GB内存开销

- 文件句柄、上下文切换频率也随线程增长而上升

因此采取折衷策略:

new ThreadPoolExecutor(200, // corePoolSize: 保证基本并发能力400, // maxPoolSize: 高峰弹性扩容60L, TimeUnit.SECONDS,new ArrayBlockingQueue<>(100), // 有界队列防堆积new CallerRunsPolicy() // 超载时由调用者线程承担,防止雪崩

);第四步:压测验证 + 监控闭环

调整后再次压测(50QPS持续负载):

- P99延迟从 >25s 下降至 <300ms

- CPU利用率提升至 65%~75%,算力被有效利用

- 内存稳定,无频繁GC或OOM

配合监控告警:

- 实时观测队列长度、活跃线程数、拒绝率

- 结合日志追踪慢请求源头,持续优化 W/C 比例

关于 Netty 的 “2N”:它没错,但你用错了场景!

Netty 中推荐 EventLoopGroup(2 * N) 是合理的,但其适用前提是特定的I/O模型:

- 处理的是 本地Socket事件(epoll/kqueue驱动)

- 编解码极快(C ≈ 几微秒)

- I/O等待主要来自协议交互,W/C ≈ 1 → 公式结果 ≈ 2N

所以,“2N” 是 Netty 自身通信场景下的最优解。

但它 不能直接套用于业务线程池,尤其是涉及远程调用、慢接口等 W >> C 的场景。

记住:

“2N” 是 Netty 的答案,不是你的通用解法。

避坑指南:三不要原则

| 坑点 | 正确做法 |

|---|---|

| 不要无脑设 2N | 先测 W/C 比例,再算理论线程数 |

| 不要用无界队列兜底 | 使用有界队列 + 合理拒绝策略(如 CallerRunsPolicy) |

| 忽视系统资源上限 | 综合评估内存、句柄、上下文切换开销,取最小可行值 |

总结:经验是起点,公式才是武器

- “2N” 只是一个简化口诀,适用于 W ≈ C 的典型IO场景;

- 真正决定线程数量的关键是 W/C 比例;

- 当等待时间远大于计算时间(如慢接口、跨区域调用),设置 数百甚至上千线程 不仅合理,而且必要;

- 高并发不是靠背公式,而是基于数据做出精准决策。

敢于打破“2N”迷思,才能真正驾驭高并发。

雷区8:听说过 Eager(急切)模式的线程池吗? 细致说说吧

在高并发系统中,线程池是资源调度的核心组件。但很多人不知道的是:JDK 原生线程池(标准线程池)的行为,在某些场景下其实“反直觉”甚至“反性能”。

尤其是在突发流量来临时,明明还有大量线程额度可用,任务却傻等在队列里——这就是 Eager 模式线程池要解决的根本问题。

-

标准线程池:能排队就不干活

-

Eager 模式:能干活就不排队

JDK原生线程池痛点:

JDK 线程池“先排队、后扩容”的默认策略。 导致突发请求下线程资源闲置 、任务积压、响应延迟飙升,严重违背低延迟服务对快速响应的核心诉求。

Eager(急切)模式线程池,反转调度逻辑

采用 Eager(急切)模式线程池,反转调度逻辑:优先创建新线程(直到最大线程数),仅当线程真正打满时才将任务入队。

Eager(急切)模式线程池 用“主动出击”替代“被动等待”,最大化利用计算资源。

一、为什么JDK 原生线程池 / 标准线程池会“消极怠工”?

Java 默认的 ThreadPoolExecutor 工作流程如下:

**(1) 当前线程数 < corePoolSize → 创建新线程****(2) 否则,尝试将任务放入队列****(3) 若队列已满 且 当前线程数 < maxPoolSize → 创建新线程****(4) 否则,执行拒绝策略**这个逻辑看似合理,但在实际使用中埋下了大坑。

火坑 还原:

假设配置如下:

corePoolSize = 8maxPoolSize = 64queue = new ArrayBlockingQueue<>(100)此时突发 20 个请求到来:

- 前 8 个由核心线程处理

- 后 12 个直接进入队列 (尽管还有 56 个线程额度未用!)

结果是:

- 用户请求被阻塞数秒,P99 延迟急剧上升

- CPU 利用率不足 40%,算力空转

- 服务 SLA 失守,用户体验崩坏

这不是系统扛不住压力,而是线程池“宁可排队也不开线程”造成的资源浪费!

二、Eager 模式的核心思想:能干活就不排队

Eager 模式的核心哲学只有一句:

“只要还能创建线程,就不要让任务等待。”

它把原逻辑 :

先入队 → 队列满再扩容

改为:

能扩容就扩容 → 实在扩不了才入队

这样,在流量毛刺或突发调用时,系统能第一时间拉起更多线程并行处理,显著降低排队时间和整体延迟。

三、如何实现 Eager 模式?

由于 JDK 原生不支持该行为,需通过“技巧性设计”来“欺骗”线程池的调度机制。

实现原理:自定义队列 + 反向控制 offer() 行为

关键思路:

重写队列的 offer() 方法,主动拒绝入队以触发线程创建。

步骤详解:

1、自定义任务队列 TaskQueue

- 继承 LinkedBlockingQueue

- 重写 offer(Runnable) 方法

2、在 offer 中判断是否允许入队

- 如果当前线程数 < 最大线程数 → 返回 false(假装队列满)

- 触发线程池走“创建新线程”路径

- 只有当线程真打满了,才允许入队

3、配合自定义线程池统计提交任务数

- 跟踪“已提交但未完成”的任务量,辅助决策

Eager(急切)模式线程池 核心实现示例代码(简化版):

本质:利用线程池“队列满 → 尝试扩容”的机制,人为制造“假满”状态,提前触发线程创建。

实现 Eager(急切)模式线程池的核心在于“欺骗” ThreadPoolExecutor。

根据 JDK 的源码逻辑,只有当 queue.offer() 返回 false 时,线程池才会去创建非核心线程。

因此,我们需要构建一个“虚假”的队列,在线程还没达到 maxPoolSize 之前,故意告诉线程池队列已满。

以下是实现 Eager 模式的三个核心步骤及源码级实现方案:

1. 第一步:自定义任务队列 TaskQueue

我们要重写 offer 方法。这个方法是线程池提交任务时的关键入口。

public class TaskQueue<R extends Runnable> extends LinkedBlockingQueue<Runnable> {private EagerThreadPoolExecutor executor;public void setExecutor(EagerThreadPoolExecutor executor) {this.executor = executor;}@Overridepublic boolean offer(Runnable runnable) {int currentPoolSize = executor.getPoolSize();// 核心逻辑:如果当前线程数 < 最大线程数,返回 false// 目的:迫使 ThreadPoolExecutor 创建新线程,而不是进入队列if (currentPoolSize < executor.getMaximumPoolSize()) {return false; }// 如果线程已经达到 maxPoolSize,则真正尝试进入队列return super.offer(runnable);}// 补偿逻辑:当线程池因为队列返回 false 试图创建线程却失败时(例如达到上限)// 需要一个方法强制把任务塞进队列public boolean retryOffer(Runnable o, long timeout, TimeUnit unit) throws InterruptedException {if (executor.isShutdown()) {throw new RejectedExecutionException("Executor is shutdown!");}return super.offer(o, timeout, unit);}

}2. 第二步:自定义线程池 EagerThreadPoolExecutor

线程池需要配合队列工作。

当 offer 返回 false 导致线程池去创建线程,如果创建失败(比如瞬时竞争严重),我们需要在拒绝策略执行前,给任务最后一次进队列的机会。

public class EagerThreadPoolExecutor extends ThreadPoolExecutor {public EagerThreadPoolExecutor(int corePoolSize, int maximumPoolSize, long keepAliveTime, TimeUnit unit, TaskQueue<Runnable> workQueue, ThreadFactory threadFactory) {super(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue, threadFactory);workQueue.setExecutor(this);}@Overridepublic void execute(Runnable command) {try {super.execute(command);} catch (RejectedExecutionException rx) {// 此时说明:1. offer返回了false 2. 线程数已达max。// 按照Eager模式,这时候任务应该乖乖去队列排队了。final TaskQueue queue = (TaskQueue) getQueue();try {// 强制尝试入队,如果此时队列也满了,才真正抛出拒绝异常if (!queue.retryOffer(command, 0, TimeUnit.MILLISECONDS)) {throw new RejectedExecutionException("Queue is full.", rx);}} catch (InterruptedException x) {throw new RejectedExecutionException(x);}}}

}3. Eager 模式下的任务流转图

对比 JDK 原生模式,Eager 模式改变了任务的“旅行路线”:

(1) 提交任务:先看核心线程 corePoolSize 是否满了。

(2) 触发急切模式:核心线程满后,TaskQueue 拦截 offer(),直接返回 false。

(3) 快速扩容:线程池接到 false,立即开启新线程处理任务,直到达到 maxPoolSize。

(4) 最后入队:只有当 maxPoolSize 也用完时,execute 方法里的 catch 块才会捕获异常,并将任务塞进 workQueue 进行排队。

(5) 真正拒绝:只有线程打满且队列排满,才会报错。

4. 为什么这种模式对低延迟服务至关重要?

在你的支付回调场景中,假设突发流量从 200 飙升到 400:

- 原生模式:这多出来的 200 个任务会先在队列里“坐冷板凳”。如果每个任务耗时 300ms,排在末尾的任务延迟直接增加到了 。

- Eager 模式:检测到流量压力,瞬间拉起剩余的线程额度。任务不进队列直接上 CPU,排队延迟被压缩到接近 0ms。

四、Eager vs 标准线程池对比

| 对比维度 | 标准线程池 | Eager 模式线程池 |

|---|---|---|

| 调度优先级 | 先入队,后扩容 | 先扩容,后入队 |

| 突发流量响应速度 | 慢(任务排队) | 快(迅速拉起线程) |

| 线程利用率 | 低(常处于闲置) | 高(及时并行处理) |

| 资源消耗 | 更节省内存 | 可能创建较多线程 |

| 适用场景 | 批处理、后台任务 | RPC、API网关、实时交互服务 |

五、适用场景与注意事项

推荐使用场景:

- RPC 服务提供方(如 Dubbo Provider)

- API 网关 / 微服务入口

- 支付回调、消息推送等 IO 密集型实时任务

- 任何对 P99/P999 延迟敏感 的在线业务

️ 使用边界与风险控制:

1、maxPoolSize 必须科学设置

- 不可盲目设大,避免线程爆炸引发上下文切换开销

- 建议公式:N = N_cpu * (1 + W/C)(W: 等待时间, C: 计算时间)

2、队列必须有界且容量适中

- 建议 ≤ 50,作为最终缓冲而非主要承载

3、拒绝策略建议使用 CallerRunsPolicy

- 防止任务丢失,同时反压上游减缓流入

(4) 必须接入监控体系

- 监控指标:活跃线程数、队列长度、拒绝次数、任务耗时分布

六、开源参考与实践建议

- Apache Dubbo:org.apache.dubbo.common.threadpool.support.eager.EagerThreadPool

- Alibaba Sentinel:部分限流线程池借鉴此思想

- 自研建议:

- 可基于 ThreadPoolExecutor + TaskQueue 快速封装

- 结合 Nacos/Apollo 实现参数动态调整

- 在测试环境压测验证调度行为是否符合预期

七、总结:别再让线程池“摸鱼”

-

标准线程池:能排队就不干活

-

Eager 模式:能干活就不排队

在高并发、低延迟成为标配的今天,Eager 模式不是炫技,而是保障服务质量的必要手段。

如果你的服务仍在使用默认线程池处理用户请求,请认真思考一个问题:

“我是想让用户多等几秒,还是想让 CPU 多跑一会?”

答案显而易见。

核心流程图解

图解说明:

Eager 模式通过改变 offer() 行为,在仍有线程额度时主动拒绝入队,强制触发线程扩容,从而实现“优先并行、最后排队”的高效调度。

雷区9: 线程池溢出:如果 流量瞬间超过了线程池承载能力,会发生什么?

......... 略5000字+

...................由于平台篇幅限制, 剩下的内容(5000字+),请参参见原文地址

原始的内容,请参考 本文 的 原文 地址

本文 的 原文 地址

雷区9: 优雅关闭:当系统重启或发布时,线程池里没跑完的任务怎么处理?

......... 略5000字+

...................由于平台篇幅限制, 剩下的内容(5000字+),请参参见原文地址

原始的内容,请参考 本文 的 原文 地址

本文 的 原文 地址

雷区10: 多线程“假死”:怎么排查一个“看似卡住”的多线程程序?

......... 略5000字+

...................由于平台篇幅限制, 剩下的内容(5000字+),请参参见原文地址

原始的内容,请参考 本文 的 原文 地址

本文 的 原文 地址