AI时代代码质量提升实战指南:别让效率成为质量的敌人

请关注公众号【碳硅化合物AI】

摘要

AI代码生成工具确实让开发效率大幅提升,但同时也带来了新的挑战:代码质量参差不齐、技术债务快速积累、团队对代码理解不深。这篇文章从实际问题出发,结合DevOps、DORA模型、SPACE框架等先进工程管理理念,提出了一套在AI开发模式下保障代码质量的实战方案。通过质量内建、左移测试、价值流分析、度量驱动改进等系统性方法,在享受AI效率红利的同时,确保代码质量不滑坡。文章不仅提供了理论框架,还给出了可落地的实施路径和关键成功因素。

问题:AI开发模式下的质量困境

现在很多团队都在用AI工具生成代码,效率确实上来了,但问题也接踵而至。我见过不少团队,刚开始用AI的时候特别兴奋,觉得终于可以解放双手了,结果用了一段时间发现,代码是写出来了,但质量却越来越差,最后反而更累了。

代码理解盲区:你不知道AI在想什么

最头疼的问题就是代码理解盲区。AI生成的代码不是你手写的,你对代码逻辑不熟悉,就像看别人写的代码一样,总觉得哪里不对劲,但又说不出来。我有个同事,用AI生成了一个复杂的算法,看起来逻辑是对的,但运行起来就是有问题。他花了半天时间才找到问题,原来是AI在边界条件处理上有个小bug,但这个小bug藏得很深,不仔细看根本发现不了。

更麻烦的是,当代码出问题的时候,你都不知道AI是怎么想的。传统的代码,你至少知道作者当时的思路,但AI生成的代码,你只能靠猜。这就违背了"代码即文档"的理念,导致知识传递断层。新人接手项目的时候,看到一堆AI生成的代码,完全不知道从哪下手。

死代码堆积:项目里的"僵尸军团"

需求变化快,AI生成的代码中很多已经用不上了,但开发者识别不出来。我见过一个项目,代码库里有30%的代码都是死代码,都是AI生成的,但没人敢删,因为不知道删了会不会出问题。这些"僵尸代码"不仅占用资源,还增加了维护成本。每次重构的时候,都要先花时间搞清楚哪些代码是活的,哪些是死的。

更糟糕的是,AI生成的代码往往有很多变体,同一个功能可能有三种不同的实现方式,都躺在代码库里。你改了一个,发现还有两个,改来改去,最后都不知道哪个是对的。

质量参差不齐:AI也有"心情不好"的时候

AI生成的代码量大,但质量不稳定。有时候生成的代码特别好,有时候生成的代码就是垃圾。我见过AI生成的一个方法,有200多行,圈复杂度高达25,正常人根本写不出这样的代码。但AI就生成了,而且看起来还能跑,就是没人敢动。

缺乏统一的质量标准,导致技术债务快速积累。每个开发者用AI的方式不一样,生成的代码风格也不一样,最后整个项目的代码质量被拉低。你看着代码库,就像看一个拼凑起来的怪物,每个部分都长得不一样。

测试用例负担:数量不等于质量

AI虽然能生成测试用例,但大量用例的维护成本也很高。我见过一个项目,AI生成了500多个测试用例,但真正有用的可能就100个。剩下的400个,要么是重复的,要么是测试边界情况但实际不会发生的,要么就是测试用例本身就有问题。

更麻烦的是,这些测试用例的维护成本很高。每次代码改动,都要检查这些测试用例要不要改。有些测试用例写得特别复杂,你都不知道它在测试什么。最后,测试用例反而成了负担,而不是保障。

恶性循环:越跑越快,越跑越偏

AI让开发变快,项目进度更紧,更没时间重构和优化。这形成了"快速开发-质量下降-维护困难-更没时间优化"的死亡螺旋

我见过一个团队,用AI快速开发了一个功能,上线后发现性能有问题,但没时间优化,只能加机器。结果成本越来越高,技术债务越积越多,最后整个项目都推倒重来了。

管理误区:AI不是万能的

老板觉得AI万能,只关注速度,不断催促进度。但AI只是工具,不是魔法。我见过一个老板,看到AI能生成代码,就要求团队把开发时间缩短一半。结果团队为了赶进度,用AI生成了大量低质量代码,最后项目延期了,因为花在修复bug上的时间比开发时间还长。

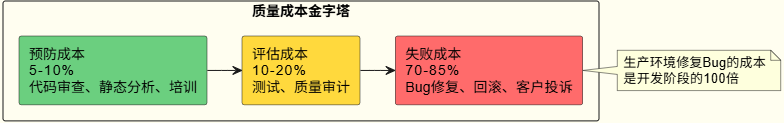

缺乏对质量成本的正确认知,是很多管理层的通病。他们不知道,在生产环境修复一个bug的成本,是在开发阶段修复的100倍。他们只看到AI带来的效率提升,没看到质量下降带来的成本增加。

这些问题如果不解决,AI带来的效率提升最终会被技术债务吞噬。根据DORA研究报告,高质量团队的部署频率是低质量团队的200倍,而变更失败率只有后者的1/3。这说明质量不是效率的敌人,而是效率的基石。你只有把质量做好了,才能真正提升效率。

方法论:质量与效率的平衡之道

核心理念:质量内建(Quality Built-in)

在AI开发模式下,我们需要建立"质量内建"的理念。这不是说不要效率,而是要在保证质量的前提下提升效率。就像丰田生产系统的"质量内建"理念,质量不是检查出来的,而是设计出来的。

以前我们做质量保障,都是在代码写完之后再检查,发现问题再改。这种方式效率低,成本高。现在我们要把质量保障前移到开发阶段,在写代码的时候就保证质量。这样虽然前期投入多一点,但后期成本会大幅降低。

质量内建的核心思想:

左移测试(Shift Left):把质量保障活动前移到开发阶段,而不是等到测试阶段才发现问题。AI生成的代码应该在提交前就完成质量检查。我见过一个团队,他们在本地就配置了pre-commit hook,每次提交代码前都会自动运行静态分析和单元测试。虽然每次提交多花了几秒钟,但避免了后期大量的bug修复工作。

持续反馈:建立快速反馈机制,让开发者能够立即知道代码质量问题,而不是等到代码审查或测试阶段。以前我们发现问题可能要等几天,现在几分钟就能知道。这样开发者可以立即修复问题,不会让问题积累。我见过一个团队,他们在IDE里集成了代码质量检查,写代码的时候就能看到问题提示,就像写Word文档时的拼写检查一样。

自动化优先:尽可能用自动化工具替代人工检查,减少人为错误,提高一致性。人工检查容易漏掉问题,而且不同的人标准不一样。自动化工具可以保证一致性,而且不会累。我见过一个团队,他们用自动化工具检查代码,发现的问题比人工检查多30%,而且检查时间缩短了80%。

理论基础:DORA模型与SPACE框架

DORA核心指标

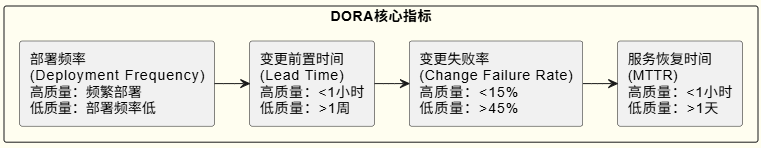

DORA(DevOps Research and Assessment)研究定义了四个关键指标来衡量研发效能:

关键洞察:高质量团队不是通过降低部署频率来保证质量,而是通过质量内建实现高频部署且低失败率。

SPACE框架

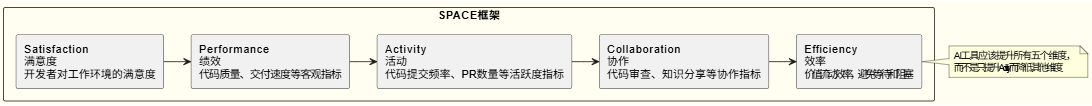

SPACE框架从五个维度评估研发效能:

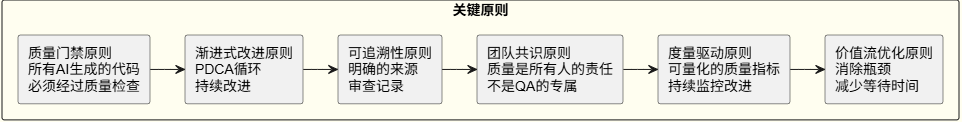

关键原则

如何解决问题

1. 认识层面:打破"人月神话"的陷阱

1.1 对老板和管理层:理解质量成本模型

很多老板觉得,做质量保障就是花钱,看不到直接收益。其实不是这样的,质量保障是投资,不是成本。你前期投入一点,后期能省很多。

质量成本金字塔:

关键洞察:在AI开发模式下,预防成本虽然增加了(需要审查AI生成的代码),但失败成本会大幅降低。根据IBM的研究,在生产环境修复一个Bug的成本是在开发阶段修复的100倍。也就是说,你在开发阶段花1小时修复bug,相当于在生产环境节省100小时。

我见过一个团队,他们用AI生成代码,但坚持做代码审查。虽然每次审查多花了30分钟,但避免了后期大量的bug修复工作。算下来,他们花在质量保障上的时间,比不做质量保障的团队少了一半。

建议措施:

设定合理的质量指标:不要只看代码量,要看代码质量。设定代码覆盖率、技术债务率、变更失败率等指标,纳入项目考核。我见过一个团队,他们把代码质量指标纳入KPI,结果代码质量提升了40%,bug数量减少了60%。

建立质量成本模型:量化质量投入的ROI。让老板看到,花在质量保障上的钱,能带来多少收益。我见过一个团队,他们做了一个质量成本模型,发现花在质量保障上的每1块钱,能节省10块钱的失败成本。老板看到这个数据,立马就支持了。

采用DORA指标衡量团队效能:不要只看开发速度,要看交付质量和稳定性。DORA指标能全面反映团队的效能,包括部署频率、变更前置时间、变更失败率、MTTR等。我见过一个团队,他们用DORA指标衡量效能,发现虽然开发速度不是最快的,但交付质量是最好的,客户满意度也是最高的。

为质量活动预留时间预算:建议每个迭代20%时间用于质量保障。这20%的时间包括代码审查、重构、技术债务清理等。我见过一个团队,他们每个迭代都预留20%的时间做质量保障,结果技术债务越来越少,开发速度反而越来越快。

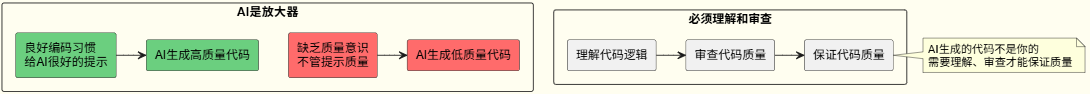

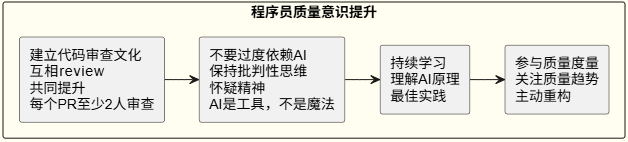

1.2 对程序员:建立质量意识

很多程序员觉得,用AI生成代码,自己就不用管质量了。其实不是这样的,AI是放大器,不是替代品。

建议措施:

2. 软件工程方法论:建立质量保障体系

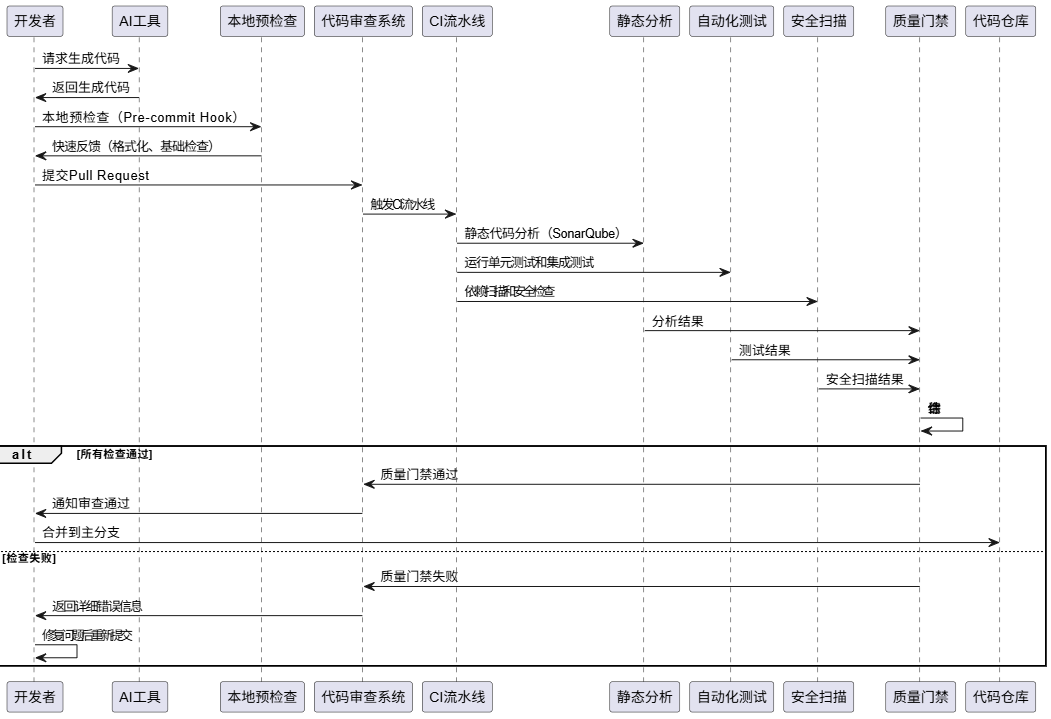

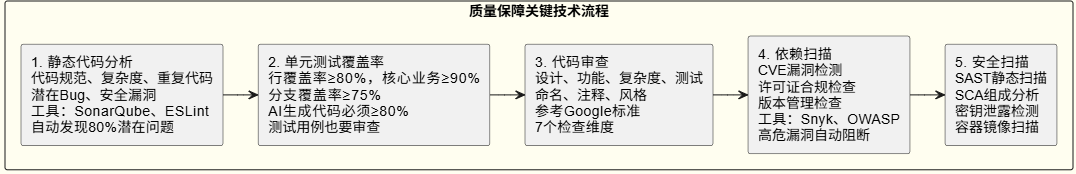

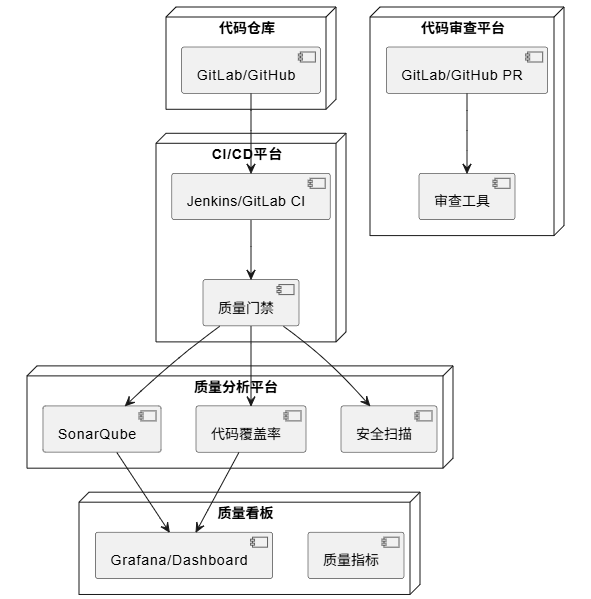

2.1 质量门禁机制:CI/CD流水线集成

质量门禁不是简单的检查点,而是贯穿整个开发流程的自动化质量保障体系。

关键技术点详解:

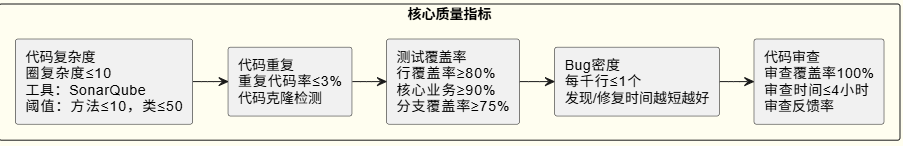

1. 静态代码分析(Static Code Analysis)

静态代码分析能自动发现80%以上的潜在问题,比人工检查效率高得多。建议先用语言特定工具(ESLint、Pylint等),上手后再用SonarQube等综合性工具。阈值设定要合理:代码覆盖率≥80%,圈复杂度≤10,重复代码率≤3%,技术债务率≤5%。

2. 单元测试覆盖率

AI生成代码必须达到80%以上覆盖率(核心业务≥90%),测试用例也要经过审查确保有效性。

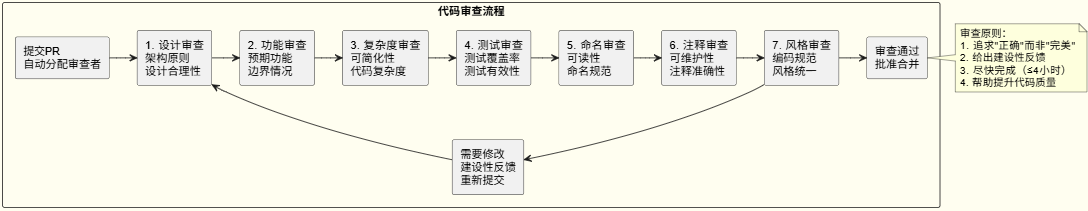

3. 代码审查流程(Code Review)

代码审查是质量保障的关键环节,参考Google标准,重点关注7个维度:

代码审查要给出建设性反馈,帮助作者提升代码质量,而不是简单找茬。

4. 依赖扫描(Dependency Scanning)

使用Snyk、OWASP Dependency-Check等工具检测CVE漏洞、许可证合规和版本管理。高危漏洞自动阻断合并。

5. 安全扫描(Security Scanning)

包括SAST(SonarQube、Checkmarx)、SCA(Snyk、WhiteSource)、密钥泄露检测(GitGuardian)和容器镜像扫描(Trivy)。

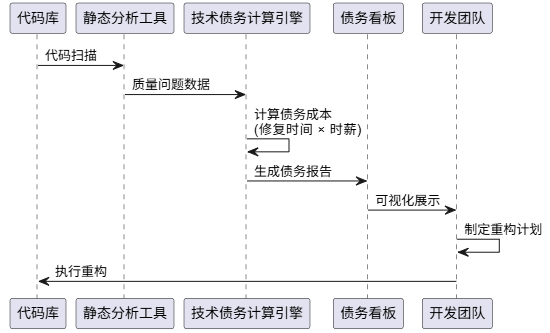

2.2 技术债务管理:量化与可视化

技术债务不是"欠债",而是"投资决策"。关键是要量化债务成本,让管理层看到债务的代价。

技术债务量化模型:

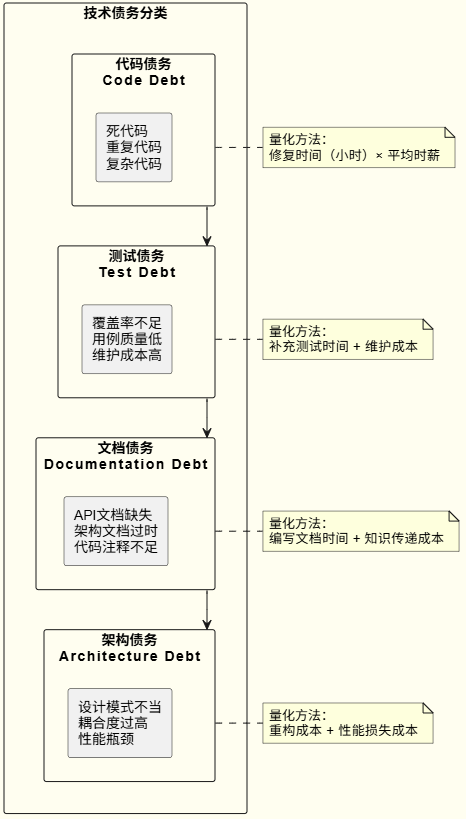

技术债务分类:

技术债务管理流程:

- 识别:使用工具自动识别(SonarQube、CodeClimate)

- 评估:评估债务的严重程度和修复成本

- 优先级:根据业务影响和技术影响确定优先级

- 计划:制定重构计划,分配资源

- 执行:每个迭代预留20%时间用于技术债务清理

- 监控:持续监控债务趋势,防止债务积累

技术债务预算(Technical Debt Budget):

- 每个迭代预留20%时间用于技术债务清理

- 新功能开发时,如果引入技术债务,必须在同一迭代内清理

- 建立技术债务看板,可视化债务趋势

2.3 代码质量度量:建立质量仪表盘

建立可量化的质量指标,用数据驱动质量改进。

核心质量指标(Quality Metrics):

质量仪表盘(Quality Dashboard):

建立实时质量仪表盘,可视化展示:

- 质量趋势:代码质量随时间的变化趋势

- 质量分布:不同模块、不同团队的质量分布

- 技术债务趋势:技术债务的积累和清理趋势

- DORA指标:部署频率、变更前置时间、变更失败率、MTTR

度量驱动改进(Metrics-Driven Improvement):

- 设定基线:建立当前质量基线

- 设定目标:设定改进目标(SMART原则)

- 持续监控:定期检查质量指标

- 分析根因:当指标异常时,分析根本原因

- 采取行动:制定改进措施并执行

- 验证效果:验证改进措施是否有效

3. 关键措施:从规范到执行的完整体系

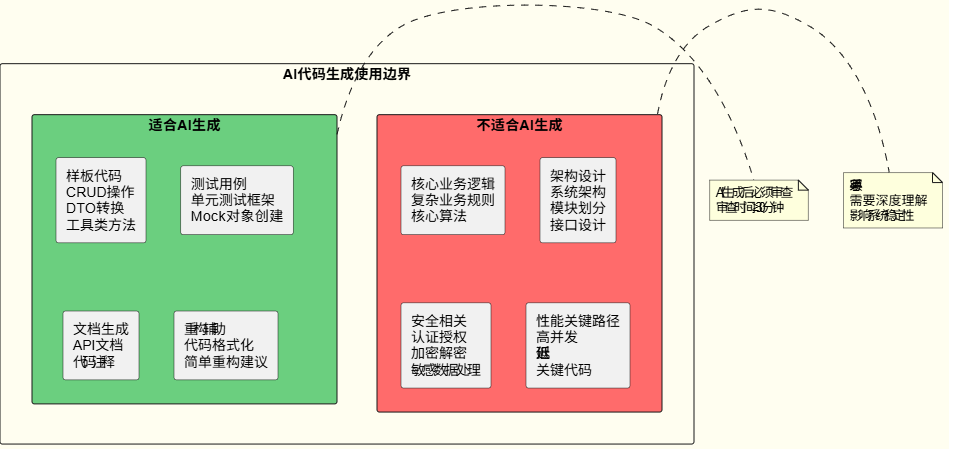

3.1 AI代码生成规范:建立使用边界

明确生成范围:

AI代码生成使用边界:

生成后必审查:AI生成的代码必须经过人工审查(≥30分钟),审查重点包括逻辑正确性、安全性、性能、可维护性。保留生成记录,建立AI代码知识库。

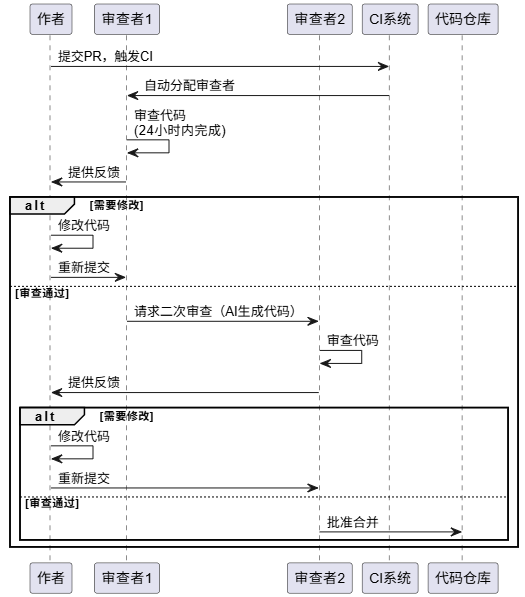

3.2 代码审查机制:Google标准实践

代码审查不是找茬,而是知识传递和质量保障。

审查流程:

审查原则(Google Code Review Standards):

- 审查者应该批准那些改进代码库的PR,即使不完美

- 审查者应该追求"正确"而不是"完美"

- 审查者应该给出建设性的反馈,解释为什么需要修改

- 审查者应该尽快完成审查,不要阻塞开发者

审查清单(Code Review Checklist):

审查时间管理:

- 小型PR(<200行):审查时间≤2小时

- 中型PR(200-500行):审查时间≤4小时

- 大型PR(>500行):建议拆分成多个小PR

- AI生成的代码:审查时间≥30分钟

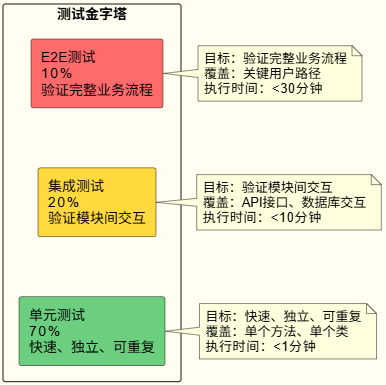

3.3 测试策略优化:测试金字塔实践

遵循测试金字塔原则,建立分层的测试策略。

测试金字塔:

1. 单元测试(Unit Tests)- 70%

快速、独立、可重复,执行时间<1分钟。覆盖单个方法、单个类,用Mock和Stub隔离外部依赖。AI生成代码必须编写单元测试,测试用例也要经过审查。

2. 集成测试(Integration Tests)- 20%

验证模块间交互,覆盖API接口、数据库交互、外部服务调用,执行时间<10分钟。

3. 端到端测试(E2E Tests)- 10%

验证完整业务流程,只测试关键用户路径,执行时间<30分钟。

测试用例质量:关注有效性而非数量,审查是否覆盖所有分支和边界情况,定期优化删除冗余用例。

自动化回归:每次代码提交、每日构建、发布前触发,并行执行缩短时间,失败立即通知。

4. 组织支撑:构建质量文化

质量不是工具和流程的问题,而是文化和组织的问题。

4.1 质量文化:从"质量是QA的责任"到"质量是每个人的责任"

文化转变:

- 旧观念:质量是QA的责任,开发只管写代码

- 新观念:质量是每个人的责任,开发要对自己的代码质量负责

建立质量文化的关键措施:

- 领导示范:管理层要重视质量,为质量活动提供资源支持

- 质量分享:定期组织质量分享会,分享最佳实践和失败案例

- 质量奖励:设立质量奖,奖励质量优秀的团队和个人

- 质量培训:定期组织质量培训,提升团队的质量意识

4.2 培训体系:持续学习与改进

培训内容:

-

代码质量基础:

- 编码规范:团队编码规范、最佳实践

- 代码审查:如何做好代码审查

- 测试策略:如何编写有效的测试用例

-

工具使用:

- 静态分析工具:SonarQube、Checkstyle等

- 测试框架:JUnit、TestNG、Mockito等

- CI/CD工具:Jenkins、GitLab CI、GitHub Actions等

-

AI工具使用:

- 如何有效使用AI生成代码

- 如何审查AI生成的代码

- 如何优化Prompt提升AI生成代码质量

培训方式:

- 内部培训:技术分享会、代码审查工作坊

- 外部培训:参加行业会议、在线课程

- 实践驱动:通过实际项目实践,边做边学

4.3 激励机制:质量与绩效挂钩

质量指标纳入绩效考核:

-

个人指标:

- 代码审查参与度:审查PR数量、审查质量

- 代码质量:代码复杂度、测试覆盖率

- 技术债务清理:清理的技术债务数量

-

团队指标:

- DORA指标:部署频率、变更失败率、MTTR

- 质量趋势:代码质量趋势、技术债务趋势

- 质量文化:质量分享次数、质量改进提案

奖励机制:

- 质量之星:每月评选质量优秀的开发者

- 质量团队:每季度评选质量优秀的团队

- 质量改进奖:奖励提出质量改进建议的团队

4.4 工具支持:降低质量保障成本

工具选型原则:自动化优先、集成友好、易于使用、可扩展性

推荐工具栈:

- 代码质量分析:SonarQube、CodeClimate

- 代码审查:GitHub、GitLab、Phabricator

- CI/CD:Jenkins、GitLab CI、GitHub Actions

- 测试框架:JUnit、TestNG、Pytest

- 依赖扫描:Snyk、OWASP Dependency-Check

- 安全扫描:Checkmarx、Veracode

如何落地:以公司级研发产品线为例

阶段一:建立基础(1-2个月)

这个阶段是最关键的,基础打不好,后面就很难推进了。我见过一个团队,他们想一步到位,结果工具配置不好,流程也不清楚,团队就不愿意用了。所以,这个阶段要稳扎稳打,先把基础打好。

1.1 搭建质量平台

搭建质量平台是第一步,也是最关键的一步。平台搭建好了,后面的工作就好做了。我见过一个团队,他们花了一个月时间搭建平台,配置工具,建立流程。虽然前期投入大,但后面就轻松了。

技术架构:

架构设计要简单,不要搞得太复杂。我见过一个团队,他们设计了很复杂的架构,结果维护成本很高,团队也不愿意用。后来他们简化了架构,只保留核心功能,团队就愿意用了。

实施步骤:

1. 集成SonarQube:安装配置服务器(注意性能),配置合理的质量阈值(建议从低阈值开始逐步提高),集成到CI/CD流水线实现自动化。

2. 配置CI/CD流水线:建立标准化的CI/CD模板(简单易用),集成质量门禁(避免误报),配置自动化通知机制(及时但不频繁)。

3. 建立代码审查流程:配置代码审查工具(GitLab/GitHub PR),建立明确的审查规则和流程,配置合理的通知机制。

1.2 制定规范

规范文档:

-

AI代码生成规范:

- 明确AI生成代码的使用场景

- 规定AI生成代码的审查要求

- 建立AI代码知识库

-

代码审查清单:

- 制定标准化的审查清单

- 明确审查重点和标准

- 建立审查反馈模板

-

质量指标阈值:

- 代码覆盖率:新增代码≥80%

- 圈复杂度:单个方法≤10

- 重复代码率:≤3%

- 技术债务率:≤5%

阶段二:试点推广(2-3个月)

2.1 选择试点项目

试点项目选择标准:

- 中等规模:代码量在1-5万行之间

- 活跃开发:有持续的开发活动

- 团队配合:团队愿意尝试新流程

- 代表性:能代表公司主要技术栈

试点实施步骤:

-

项目启动会:

- 介绍质量保障体系

- 明确试点目标和期望

- 解答团队疑问

-

流程执行:

- 严格执行质量流程

- 记录问题和反馈

- 每周进行回顾和改进

-

数据收集:

- 收集质量指标数据

- 收集团队反馈

- 分析流程效果

2.2 培训团队

培训计划:

-

质量意识培训(2小时):

- 质量成本模型

- 质量内建理念

- DORA指标介绍

-

工具使用培训(4小时):

- SonarQube使用

- CI/CD流程

- 代码审查工具

-

实践工作坊(4小时):

- 代码审查实战

- 测试用例编写

- 质量指标解读

阶段三:全面推广(3-6个月)

3.1 推广到所有项目

推广策略:

-

分批推广:

- 第一批:核心项目(1个月)

- 第二批:重要项目(1个月)

- 第三批:所有项目(1个月)

-

建立质量看板:

- 可视化质量指标

- 实时监控质量趋势

- 自动生成质量报告

-

定期质量回顾:

- 每月质量回顾会

- 分析质量趋势

- 识别改进机会

3.2 持续优化

优化机制:

-

度量驱动改进:

- 定期分析质量指标

- 识别异常和趋势

- 制定改进措施

-

反馈循环:

- 收集团队反馈

- 分析流程问题

- 持续优化流程

-

最佳实践沉淀:

- 总结成功经验

- 形成最佳实践文档

- 在团队内部分享

关键成功因素

1. 管理层支持

如何获得管理层支持:

- 数据说话:用数据展示质量问题的成本

- ROI分析:展示质量投入的回报

- 对标分析:对比行业最佳实践

- 试点成果:用试点项目的成果说服管理层

2. 工具自动化

自动化原则:

- 能自动化的绝不人工:减少人为错误,提高一致性

- 快速反馈:自动化检查要在几分钟内完成

- 集成友好:工具要能无缝集成到开发流程中

3. 循序渐进

实施策略:

- 不要一次性要求太高:逐步提升标准

- 先易后难:先实施容易的,再实施困难的

- 允许试错:给团队试错和调整的空间

4. 持续改进

改进机制:

- 定期回顾:每月进行质量回顾

- 数据驱动:用数据指导改进方向

- 快速迭代:小步快跑,持续优化

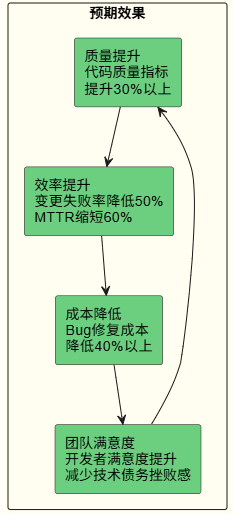

预期效果

总结

AI代码生成工具确实能大幅提升开发效率,但我们不能忽视代码质量。通过建立质量内建、左移测试、价值流分析、度量驱动改进等系统性方法,可以在享受AI效率红利的同时,确保代码质量不滑坡。

核心观点

- 质量内建,而非事后检查:质量不是检查出来的,而是设计出来的。要将质量保障活动前移到开发阶段,建立质量门禁机制。

- 效率和质量相辅相成:根据DORA研究,高质量团队的部署频率是低质量团队的200倍,而变更失败率只有后者的1/3。高质量不是效率的敌人,而是效率的基石。

- 度量驱动改进:建立可量化的质量指标,用数据说话。通过DORA指标、SPACE框架、质量仪表盘等工具,持续监控和改进。

- 技术债务要量化管理:技术债务不是"欠债",而是"投资决策"。要量化债务成本,让管理层看到债务的代价,建立债务管理机制。

- 组织文化是关键:质量不是工具和流程的问题,而是文化和组织的问题。要建立"质量是每个人的责任"的文化氛围。

行动建议

对管理层:

- 理解质量成本模型,认识到质量投入的ROI

- 为质量活动提供资源支持,预留质量预算

- 将质量指标纳入绩效考核,建立激励机制

对技术团队:

- 建立质量内建意识,不要依赖后期测试

- 善用AI工具,但保持对代码的掌控力

- 参与质量度量,了解自己的代码质量趋势

对组织:

- 建立质量文化,从"质量是QA的责任"到"质量是每个人的责任"

- 提供工具和平台支持,降低质量保障成本

- 持续学习和改进,跟上行业最佳实践

未来展望

随着AI技术的不断发展,代码生成能力会越来越强,但质量保障的重要性不会降低,反而会更加重要。我见过一些团队,他们觉得AI这么强,质量保障就不需要了。结果代码质量越来越差,最后还是要做质量保障。

持续学习:AI技术在快速发展,我们要跟上节奏。我见过一个团队,他们定期学习AI技术,了解最新的工具和方法,结果用AI的效率越来越高。另一个团队,他们不学习,还用老方法,结果效率就低了。

持续改进:质量保障体系不是一成不变的,要根据实践经验持续优化。我见过一个团队,他们每个季度都会回顾质量保障体系,发现问题就改进,结果体系越来越完善。

持续创新:AI在质量保障中的应用还有很多空间。比如AI代码审查,可以自动发现一些问题,减轻审查者的负担。AI测试生成,可以自动生成测试用例,提高测试效率。我见过一个团队,他们用AI做代码审查,发现问题的效率提升了50%。

但记住,AI是工具,不是替代品。我们要善用AI,但不能被AI绑架。我见过一个团队,他们完全依赖AI,结果AI出错了,他们也不知道,最后出了问题。只有保持对代码的掌控力,建立完善的质量保障体系,才能在AI时代走得更远。

写在最后

质量保障不是一朝一夕的事,需要长期坚持。我见过很多团队,他们一开始很重视质量保障,但坚持了一段时间就松懈了,结果质量又下降了。所以,质量保障要成为习惯,成为文化,才能持续下去。

另外,质量保障不是一个人的事,是整个团队的事。我见过一个团队,他们只有QA在做质量保障,结果质量还是不好。后来他们让所有人都参与质量保障,质量就提升了。

最后,质量保障不是成本,是投资。你前期投入一点,后期能省很多。我见过一个团队,他们不愿意做质量保障,结果后期花在修复bug上的时间,比做质量保障的时间多10倍。所以,质量保障是值得的。

希望这篇文章能帮助正在使用AI工具开发的团队,建立完善的质量保障体系,在享受AI效率红利的同时,确保代码质量不滑坡。记住,质量不是效率的敌人,而是效率的基石。只有把质量做好了,才能真正提升效率。