- • 论文标题: GuideNav: User-Informed Development of a Vision-Only Robotic Navigation Assistant For Blind Travelers

- • 发表会议: HRI '26 (ACM/IEEE International Conference on Human-Robot Interaction)

- • 论文链接: https://arxiv.org/abs/2512.06147 (数据集已开源)

2. 核心动机

研究团队发现,虽然导盲机器人研究很多,但很少有设计真正符合盲人(BLV)的日常习惯。现有的基于高精地图(LiDAR/GPS)的方案存在巨大痛点:

- 1. 传感器缺陷: LiDAR昂贵、耗电、且容易受雨雪、玻璃门、反光地面干扰;GPS在城市高楼区和室内由于信号遮挡常常失效。

- 2. 忽视用户习惯: 盲人出行通常有固定的路线(如从家到车站),且依赖特定的交互反馈(如通过手柄感知路况)。

- 3. 缺乏数据: 现有研究极度缺乏关于“真导盲犬如何工作”以及“盲人如何行走”的高质量数据。

目标: 打造一款轻量级、低成本、能像导盲犬一样通过“记忆和重复”路线来工作的纯视觉机器人。

. 核心贡献一:GuideData 数据集

为了搞懂真正的需求,团队进行了一项大规模的形成性研究(Formative Study),并将数据开源,命名为 GuideData。

- • 内容: 包含对26位导盲犬使用者、9位训练师的访谈,以及超过15小时的导盲犬行走第一视角视频。

- • 价值: 这是目前首个全面记录导盲犬-主人交互、真实导航挑战和盲人日常出行的大规模开源数据集,为后续研究确立了“金标准”。

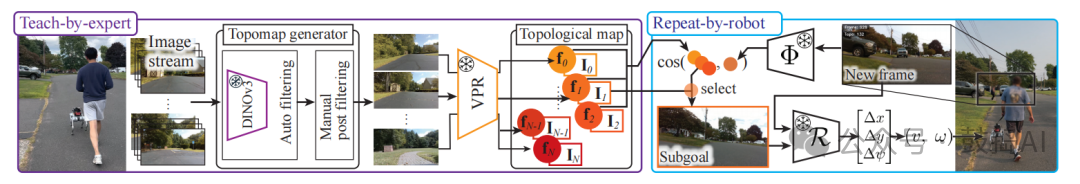

左图为真实导盲犬引导,中图为GuideNav系统界面,右图为机器人视角下的导航逻辑。

4. 核心方法:GuideNav 系统架构

GuideNav 的核心思想是视觉示教与重复(Visual Teach-and-Repeat, VT&R),模拟导盲犬的训练过程:先由人带着走一遍(示教),然后机器人自己走(重复)。

硬件配置:

- • 平台: Unitree Go2 四足机器人(具有良好的地形适应性)。

- • 传感器: 仅使用一个 Intel RealSense D435i RGB摄像头(不使用深度图,仅用RGB)。

- • 计算: NVIDIA Jetson AGX Orin。

技术流水线(Pipeline):

- 1. 示教阶段(Teach):拓扑地图构建

- • 操作员遥控机器人走一遍路线,录制视频。

- • 关键帧提取: 使用 DINOv3 大模型提取图像特征。

- • 自适应筛选: 系统根据时间间隔和图像相似度(Cosine Similarity)自动筛选关键帧,生成稀疏的拓扑地图(Topological Map)。相比密集地图,这极大降低了存储需求(1km路程仅需约24MB)。

- 2. 重复阶段(Repeat):定位与控制

- • 视觉位置识别(VPR): 实时图像经过 CosPlace 编码,与地图中的节点进行匹配,检索出当前的“子目标”(Subgoal)。为了防止匹配跳变,引入了贝叶斯滤波来保证时间一致性。

- • 相对位姿估计(核心创新): 放弃了传统的“特征匹配+PnP”方案(因为在纹理少或光照变化大时容易挂),改用 Reloc3r 神经网络。它能直接回归出当前图像与目标关键帧之间的相对位姿()。

- • 控制策略: 基于单轮车模型(Unicycle Model)的非线性反馈控制器,将位姿误差转化为机器人的线速度和角速度,驱动机器人平滑地走向子目标。

系统分为Teach(示教)和Repeat(复现)两个阶段。利用DINOv3和CosPlace强大的特征提取能力,结合Reloc3r的位姿回归,实现了鲁棒的视觉导航。

实验结果与分析

团队在室内外多种环境下进行了测试,甚至邀请了3位资深导盲犬使用者和专业训练师进行实地盲测。

- • 超长距离测试: 实现了单次 2.02公里 的户外自主导航,且没有GPS和LiDAR辅助。

- • 鲁棒性惊人:

- • 光照变化: 示教和复现即使在不同时间段(光照差异大)、有动态障碍物(行人、车辆)的情况下,成功率依然极高。

- • 成功率: 在总计近5公里的盲人测试中,实现了100%的转向成功率(46/46 TSR),仅需极少数的人工干预(主要是为了避让极其复杂的突发障碍)。

- • 用户体验(NASA-TLX & SUS):

- • 盲人参与者表示“这非常容易”、“完全自动”、“很有安全感”。

- • 相比真实导盲犬,机器人的动作略显生硬(Robotic),缺乏生物那种通过挽具传递的细腻身体语言(如减速预判),但作为导航工具已非常可靠。